La última vez que mencionamos RTX 3000 Ampere y RTX 4000 Ada. Hoy toca echar un vistazo a la nueva RTX 5000 de Blackwell. Vamos a echar un vistazo a las características de la nueva generación de tarjetas gráficas (GDDR7, DLSS), sus bloques SM y las nuevas tecnologías en Tensor Cores. También dedicaremos unas palabras a la RTX 5070.

Contenido

Características de la NVIDIA RTX 5000 Blackwell

Las principales tarjetas gráficas NVIDIA RTX Blackwell son:

- Nuevas funciones para los bloques SM Las nuevas funciones RT Core y Tensor Core mejoran y aceleran las funciones de visualización neuronal. Proporcionan el doble de rendimiento matemático por ciclo de reloj que las GPU RTX 4000 Ada

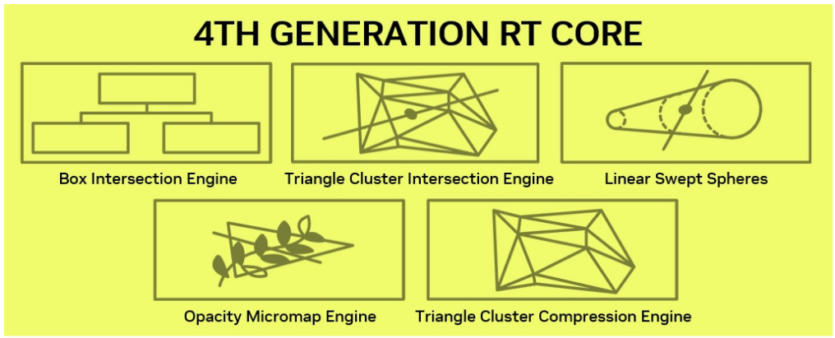

- Nuevos núcleos RT de 4ª generación. En Blackwell se han introducido mejoras significativas en la arquitectura del núcleo RT, lo que permite utilizar nuevas tecnologías de trazado de rayos e imágenes neuronales.

- Nuevos núcleos sensores de 5ª generación – incluyen nuevas funciones FP4 que pueden duplicar el rendimiento de la inteligencia artificial y reducir a la mitad los requisitos de memoria. También se incluye compatibilidad con el nuevo motor FP8 Transformer Engine de segunda generación, que se utiliza para centros de datos.

- NVIDIA DLSS 4. La arquitectura de Blackwell admite la generación de fotogramas múltiples AI, lo que aumenta la velocidad de fotogramas hasta 2 veces en comparación con la versión DLSS 3/3.5 anterior, al tiempo que mantiene o incluso supera la calidad de imagen original y garantiza una baja latencia para los sistemas.

- Procesador de gestión de inteligencia artificial (AMP) – permite modelos de IA capaces de generar conversaciones, traducción, visión de imágenes, animación, comportamiento y mucho más, y utilizar la GPU para cargas de trabajo gráficas en paralelo.

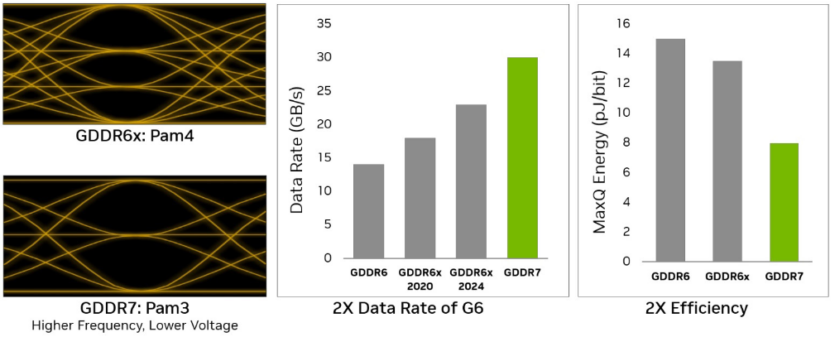

- Memoria GDDR7 — es un nuevo estándar de memoria GDDR de voltaje ultrabajo que utiliza la tecnología de señalización PAM3 (Pulse Amplitude Modulation), que incluye subsistemas de memoria más rápidos y una mayor eficiencia energética.

- Tecnología Mega Geometry – Nueva tecnología RTX para aumentar drásticamente el detalle geométrico posible en aplicaciones de trazado de rayos.

Arquitectura NVIDIA RTX 5000 Blackwell

Chip GB202 y bloques SM

El chip GB202 es el nuevo procesador estrella de la actual generación de tarjetas gráficas de consumo. Hasta ahora, sólo está disponible como parte de una nueva tarjeta gráfica GeForce RTX 5090. La GPU GB203 se utiliza en las tarjetas gráficas GeForce RTX 5080 y GeForce RTX 5070 Ti, y GB205 — en GeForce RTX 5070. Estas GPU se basan en la misma arquitectura de núcleo y están configuradas para diferentes segmentos de mercado.

Acerca de GB205 A continuación diré unas palabras por separado.

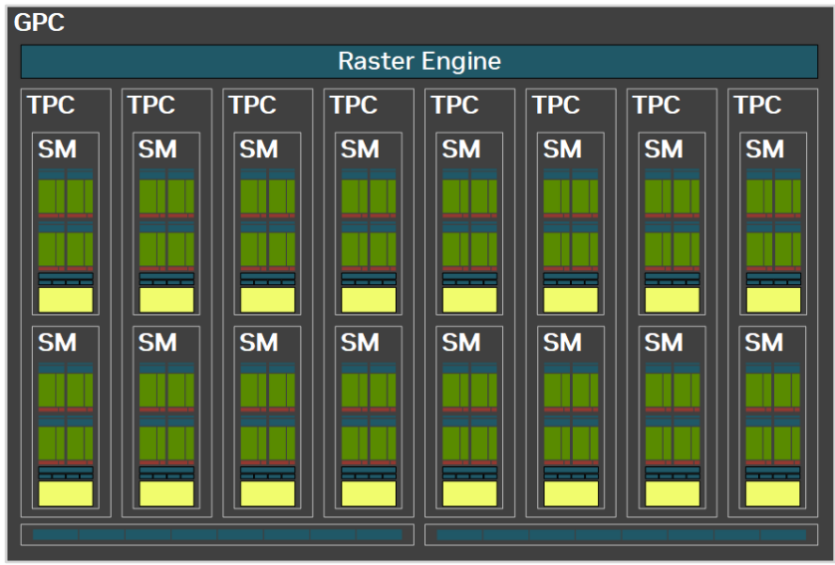

La GPU GB202 completa incluye 12 clusters de procesamiento gráfico (GPC), 96 clusters de procesamiento de texturas (TPC), 192 multiprocesadores de streaming (SM) y una interfaz de memoria de 512 bits con dieciséis controladores de memoria de 32 bits.La GPC es la unidad de hardware de alto nivel dominante en todas las GPU Blackwell GB20x, y en ella residen todas las GPU clave. Cada GPC incluye un motor de trama dedicado, dos particiones de operaciones de trama (ROP), cada una de las cuales contiene ocho ROP individuales y ocho TPC. Cada TPC incluye un motor PolyMorph y dos unidades SM.

Sin embargo, aunque la RTX 5090 tiene GB202, está ligeramente «recortada». A saber, 1 GPC está desactivado.

| GB202 (completo) | GB202 (RTX 5090) | |

| GPC | 12 | 11 |

| TPC | 96 | 85 |

| Bloques SM | 192 | 170 |

| Núcleos CUDA | 24576 | 21760 |

| Núcleos RT | 192 | 170 |

| Núcleos tensoriales | 768 | 680 |

| Caché L2 | 128 MB | 96 MB |

Imagen №1. GPU GB202. Fuente: Nvidia.

Imagen №1. GPU GB202. Fuente: Nvidia.

Cada unidad SM consta de: 128 núcleos CUDA, un núcleo RT de cuarta generación, cuatro núcleos tensoriales de quinta generación, 4 unidades de textura, un archivo de registros de 256 KB y 128 KB de memoria L1/compartida.Tenga en cuenta que el número de operaciones posibles con enteros INT32 en Blackwell se duplica en comparación con Ada debido a su unificación completa con los núcleos FP32, como se muestra en la Figura 2 a continuación. Sin embargo, los núcleos unificados sólo pueden funcionar como núcleos FP32 o INT32 en cualquier ciclo de reloj

Imagen №2. Bloque SM en la arquitectura Blackwell. Autor: Nvidia.

Imagen №2. Bloque SM en la arquitectura Blackwell. Autor: Nvidia.

Permítanme recordarles una vez más que con respecto a la RTX 4000 Ada, lo hice puesto separado. Se pueden encontrar más detalles en ese artículo. Sin embargo, incluso ahora está claro que la nueva generación será más adecuada para nuevos sombreadores neuronales y trabajos de IA.

Imagen №3. Comparación de dos generaciones de unidades SM Comparación de dos generaciones de unidades SM. Autor: Nvidia.

Imagen №3. Comparación de dos generaciones de unidades SM Comparación de dos generaciones de unidades SM. Autor: Nvidia.

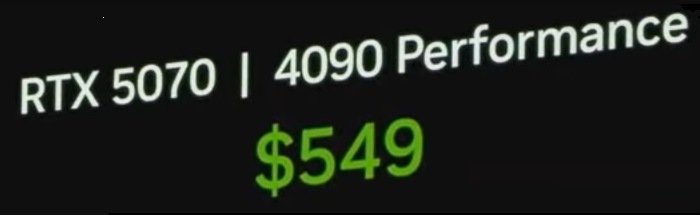

¿Qué tiene de malo la RTX 5070?

Y lo primero que habrás pensado es — No, RTX 5070 no es igual a RTX 4090. El hecho de que se dijera y mostrara esta frase en la presentación es una completa tontería. Simplemente es demasiado débil para eso. Por supuesto, si habilitas DLSS 4 con un generador de frames, entonces los fps pueden ser los mismos. Sin embargo, los retardos de pulsación y los artefactos de imagen no se pueden anular.

Imágenes №4 y №5. Una diapositiva de la presentación y un chiste de clase. Autor: NVIDIA, IndianGaming.

Sin embargo, hay algo más interesante. Aquí tienes una tabla con las características básicas de las RTX 3070/4070/5070

| RTX 3070 | RTX 4070 | RTX 5070 | |

| Chip GPU | GA104 | AD104 | GB105 |

| GPC | 6 | 5 | 5 |

| TPC | 23 | 23 | 24 |

| Bloques SM | 46 | 46 | 48 |

| Núcleos CUDA | 5888 | 5888 | 6144 |

| Núcleos tensoriales | 184 | 184 | 192 |

| Núcleos RT | 46 | 46 | 48 |

| Frecuencia de la GPU | 1725 | 2475 | 2512 |

| Neumático | 256-bit | 256-bit | 192-bit |

| Número de memoria de vídeo | 8 GB GDDR6 | 8 GB GDDR6X | 12 GB GDDR7 |

Así, podemos ver algo extraño — destaca el nombre del chip gráfico. Se trata de GB205. Este último cinco rompe todo, porque por lo general, no había tal nombre para los chips. Eran xx204 o xx206. Así que creo que la RTX 5070 se llamaba originalmente RTX 5060 o RTX 5060 Ti.

Para los interesados, la 5070 Ti tiene el mismo chip que la RTX 5080 — GB203. Y resulta que no hay GB204 intermedio, que se suponía que iba a estar en la RTX 5070

Subsistema de memoria GDDR7

Las tarjetas gráficas Blackwell incorporan la nueva memoria de vídeo GDDR7, un estándar de voltaje ultrabajo que utiliza la tecnología de señalización PAM3 para proporcionar un avance significativo en el diseño de memorias de alta velocidad. La colaboración de NVIDIA con la asociación tecnológica JEDEC ayudó a crear PAM3 (Pulse Amplitude Modulation with Three Levels). Se trata de la tecnología de señalización de alta frecuencia fundamental para la DRAM GDDR7.

Imagen №6. Comparación entre GDDR6X y GDDR7 Comparación de GDDR6X y GDDR7. Fuente: Nvidia.

Imagen №6. Comparación entre GDDR6X y GDDR7 Comparación de GDDR6X y GDDR7. Fuente: Nvidia.

La transición de PAM4 (4 niveles transmiten 2 bits por ciclo) en GDDR6X a PAM3 (3 niveles transmiten 1,5 bits por ciclo) en GDDR7, combinada con un innovador esquema de codificación de pines, permite a GDDR7 alcanzar una relación señal/ruido (SNR) significativamente mejorada. Esta evolución también duplica el número de canales independientes con un coste mínimo en términos de densidad de E/S.

Y no, no es un ordenador cuántico ni una memoria cuántica.

Con mayor densidad de canales, mejor SNR PAM3, esquemas de alineación avanzados, arquitectura de sincronización actualizada y aprendizaje de E/S mejorado, GDDR7 proporciona un rendimiento significativamente superior. La GeForce RTX 5090 viene con memoria GDDR7 de 28 Gbps y proporciona un ancho de banda de memoria máximo de 1.792 TB/s, mientras que la GeForce RTX 5080 viene con memoria GDDR7 de 30 Gbps y proporciona un ancho de banda de memoria máximo de 960 GB/s.

Núcleos tensoriales Blackwell de 5ª generación

Los núcleos de tensor Blackwell admiten operaciones con FP4, FP6, FP8, INT8, FP16, BF16 y TF32. Sin embargo, la compatibilidad con FP4 está asociada a la necesidad de ejecutar nuevos modelos generativos de inteligencia artificial. Estos modelos aumentan los requisitos de recursos informáticos y memoria, y puede resultar difícil ejecutar dichos modelos incluso en el hardware más reciente.

FP4 proporciona un método de cuantificación inferior, similar a la compresión de archivos, que reduce el tamaño del modelo. En comparación con FP16 (el predeterminado para la mayoría de los modelos), FP4 requiere menos de la mitad de memoria y las GPU Blackwell ofrecen hasta el doble de rendimiento que la generación anterior. FP4 no ofrece prácticamente ninguna pérdida de calidad gracias a las avanzadas técnicas de cuantificación que ofrece NVIDIA TensorRT Model Optimizer.

Núcleos RT Blackwell de 4ª generación

Las GPUs RTX 2000 Turing, RTX 3000 Ampere y RTX 4000 Ada disponen de bloques de hardware especiales para acelerar el recorrido de la estructura de datos BVH (Bounding Volume Hierarchy) y realizar los cálculos de intersección de triángulos de rayos y cajas de contorno de rayos. El cálculo de la intersección de rayos es una operación compleja que se realiza a alta frecuencia al renderizar una escena con trazado de rayos. El núcleo RT de cuarta generación proporciona el doble de ancho de banda que Ada.

Imagen №7. La nueva cuarta generación de núcleos RT. Autor: Nvidia.

Imagen №7. La nueva cuarta generación de núcleos RT. Autor: Nvidia.

Los núcleos RT, que se encuentran tanto en las GPU Ada como en las Blackwell, incluyen un bloque especial conocido como Opacity Micromap Engine. El motor de micromapa de opacidad evalúa la máscara de opacidad, que es una malla triangular simple definida mediante un sistema de coordenadas baricéntrico que se utiliza para informar de las intersecciones de rayos y triángulos.Los otros dos bloques (Triangle Cluster Intersection Engine y Triangle Cluster Compression Engine) para utilizar la nueva tecnología Mega Geometry.

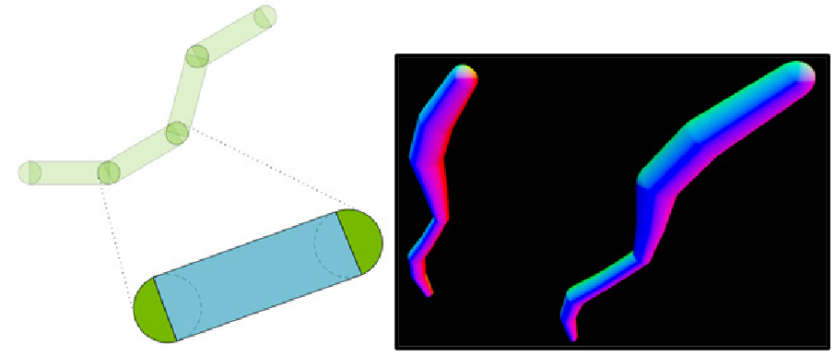

Se trata de una nueva tecnología de RTX destinada a aumentar drásticamente el detalle geométrico disponible en las aplicaciones de trazado de rayos. En concreto, Mega Geometry permite a motores de juego como Unreal Engine 5, que utilizan modernos sistemas de nivel de detalle (LOD) como Nanite, seguir su geometría con total precisión. Ya no es necesario recurrir a proxies de baja resolución para los efectos de trazado de rayos, lo que aporta nuevos niveles de calidad a las sombras, los reflejos y la iluminación indirectaDiversas variantes de las primitivas de curva se utilizan habitualmente para representar pelo, piel, hierba y otros objetos similares.

Para el trazado de rayos, estas primitivas suelen implementarse en software mediante sombreadores de intersección especiales. Sin embargo, la intersección de una curva de rayos requiere un cálculo intensivo, lo que limita el uso de curvas en el renderizado de trazado de rayos en tiempo real y aumenta el tiempo de renderizado para los renderizadores offline.

RT Core de Blackwell introduce soporte de hardware para el cruce de rayos para una nueva primitiva llamada Esferas lineales expandidas (Esferas de barrido lineal, LSS). La LSS es similar a una curva mosaico, pero se construye barriendo esferas en el espacio en segmentos lineales. Los radios de las esferas pueden variar entre los puntos inicial y final de cada segmento, lo que permite una aproximación flexible a distintos tipos de filamentos. Para casos de uso comunes, como la obtención de imágenes del cabello humano, LSS es unas 2 veces más rápido y requiere unas 5 veces menos VRAM para almacenar la geometría.

Imagen №8. Esferas de barrido lineal (LSS). Autor: Nvidia.

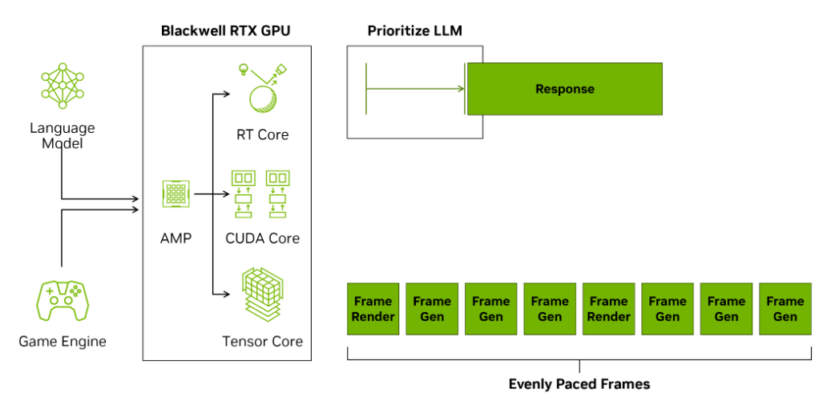

Procesador de gestión de IA (AMP)

El procesador de gestión de IA (AMP) es un programador de contextos de GPU totalmente programable diseñado para descargar contextos de la CPU a la GPU. AMP mejora la programación de contextos de la GPU de Windows para gestionar de forma más eficiente las distintas cargas de trabajo que se ejecutan en la GPU. Un contexto de GPU encapsula toda la información de estado que la GPU necesita para realizar una o más tareas. Se pueden utilizar varios contextos para garantizar que varias aplicaciones puedan utilizar la GPU simultáneamente sin conflictos. Un ejemplo es la coordinación y programación de cargas de trabajo asíncronas de inteligencia artificial como NVIDIA Avatar Cloud Engine (ACE) con modelos de habla, traducción, visión, animación y comportamiento, así como G-Assist, que se ejecutan simultáneamente con otras cargas de trabajo gráficas de la GPU.

AMP se implementa utilizando un procesador RISC-V dedicado situado en la parte frontal de la GPU y proporciona una programación más rápida de los contextos de la GPU con menor latencia que los métodos anteriores basados en la CPU. La arquitectura de programación de Blackwell AMP sigue el modelo arquitectónico de Microsoft, que describe un núcleo de programación personalizable en la GPU mediante Windows Hardware-Accelerated GPU Scheduling (HAGS), introducido en Windows 10 (Actualización de mayo de 2020). HAGS permite a la GPU gestionar su memoria de forma más eficiente, lo que reduce la latencia y mejora potencialmente el rendimiento en juegos y otras aplicaciones de uso intensivo de gráficos.

Imagen №9. AMP programa diferentes tareas. Autor: Nvidia.

Imagen №9. AMP programa diferentes tareas. Autor: Nvidia.

La función de AMP es encargarse de programar las tareas de la GPU, reduciendo la dependencia de la CPU, que suele ser el cuello de botella en el rendimiento de los juegos. De hecho, al permitir que la GPU gestione su propia cola de tareas, puede reducirse la latencia debido a la menor retroalimentación entre la GPU y la CPU. Esto se traduce en frecuencias de cuadro más fluidas en los juegos y mejor multitarea en Windows porque la CPU está menos estresada.

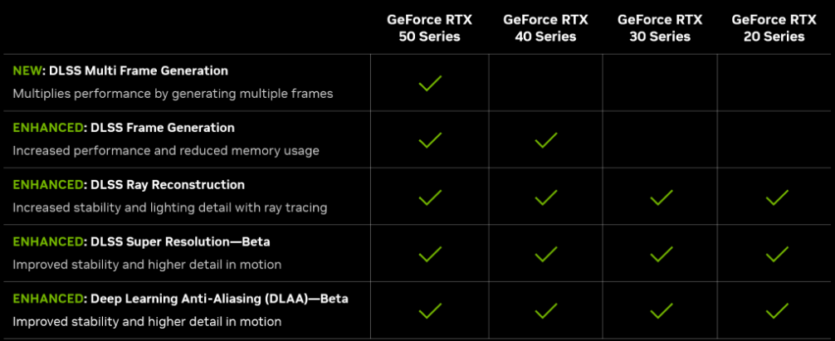

Deep Learning Super Sampling 4

Y aquí tenemos que hacer una corrección. NVIDIA utiliza ahora varias tecnologías bajo el nombre de DLSS. A saber:

- DLSS (Deep Learning Super Sampling): escalado de una imagen desde una resolución inferior a la requerida por el usuario;

- MFG (Multi Frame Generation) es el mismo generador de fotogramas adicionales entre los reales;

- RR (reconstrucción de rayos): mejora el rendimiento del trazado de rayos;

- SR (Super Resolución) – también escala la imagen;

- DLAA (Deep Learning Anti-Aliasing) es una tecnología de suavizado de imágenes.

Por lo tanto, es más apropiado sustituir la palabra Muestreo por DLSS a Servicios. Creo que será mucho más claro.

Imagen №10. Compatibilidad con nuevas tecnologías en las distintas series RTX. Fuente: Nvidia.

Imagen №10. Compatibilidad con nuevas tecnologías en las distintas series RTX. Fuente: Nvidia.

Y para los que les dé pereza seguir leyendo, NVIDIA ha preparado un vídeo especial:

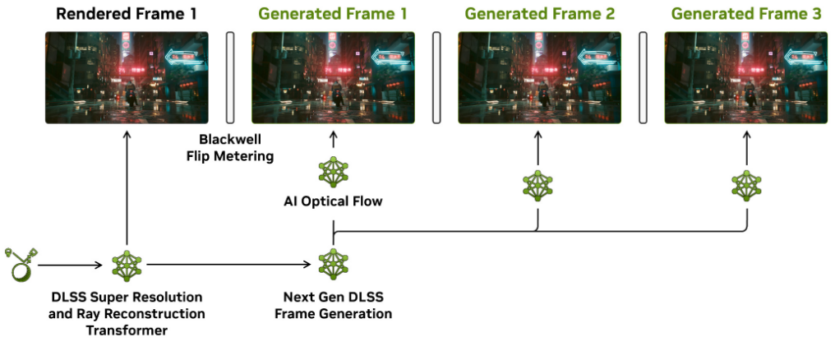

DLSS 4 Multi Frame Generation

La tecnología de generación de fotogramas se introdujo por primera vez en la arquitectura Ada en 2022. Se generaba un único fotograma entre cada par de fotogramas renderizados tradicionalmente utilizando un campo de flujo óptico junto con los vectores de movimiento del juego y la red de IA. La arquitectura de Blackwell permite que la generación de fotogramas múltiples DLSS aumente los FPS generando hasta tres miembros adicionales del personal para cada fotograma renderizado tradicionalmente.

El nuevo modelo de generación de fotogramas es un 40% más rápido, utiliza un 30% menos de memoria de vídeo y sólo requiere una ejecución por fotograma de reproducción para generar varios fotogramas. La generación del campo de flujo óptico se ha acelerado sustituyendo el flujo óptico de hardware por un modelo de IA muy eficiente

Imagen №11. Un ejemplo del trabajo de MFG. Autor: Nvidia.

Imagen №11. Un ejemplo del trabajo de MFG. Autor: Nvidia.

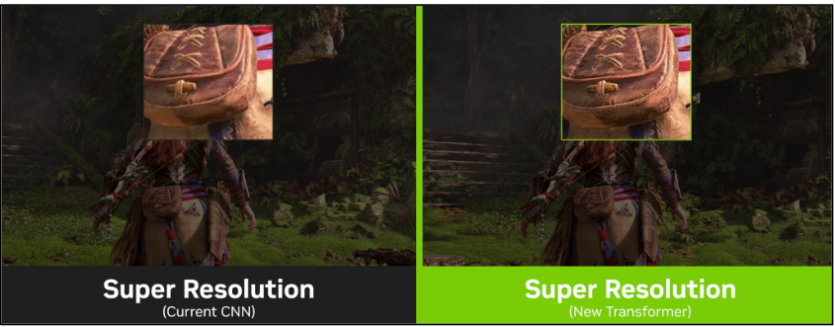

Modelos de transformadores en DLSS 4

DLSS se está pasando a una arquitectura de redes neuronales totalmente nueva, que aporta muchas ventajas. La capacidad de la inteligencia artificial para clasificar imágenes se ha visto revolucionada por una tecnología llamada red neuronal convolucional (CNN). Las CNN funcionan agregando píxeles localmente y analizando los datos en una estructura arborescente desde el nivel más bajo al más altoDLSS 4 mejora la calidad de imagen y la fluidez de renderizado introduciendo modelos de IA basados en Transformer más potentes para DLSS Super Resolution, DLSS Ray Reconstruction y Deep Learning Anti-Aliasing (DLAA), entrenados por superordenadores NVIDIA para comprender y renderizar mejor las escenas complejas. Las redes neuronales que utilizan la arquitectura Transformer destacan en tareas que implican datos secuenciales y estructurados.

La idea que subyace a los modelos Transformer es que la atención sobre cómo se gasta el cálculo y cómo se analiza debe estar dirigida por los propios datos, de modo que la red neuronal debe aprender a dirigir su atención para fijarse en las partes de los datos que son más interesantes o útiles para la toma de decisiones.

En comparación con las CNN, los Transformers utilizan la autoconciencia y pueden identificar más fácilmente patrones a largo plazo en una ventana de píxeles mucho mayor. Los Transformers también se escalan de forma más eficiente, lo que permite entrenar los modelos utilizados para DLSS 4 con el doble de parámetros y utilizar más potencia de procesamiento de los núcleos tensoriales para reconstruir imágenes con una calidad aún mejor para todos los propietarios de RTX. El resultado es una mayor estabilidad de un fotograma a otro, más detalle en la iluminación y más detalle en movimiento. El cambio de la arquitectura de la red neuronal de CNN a Transformer ha supuesto una mejora significativa de la calidad de imagen en muchos escenarios.

DLSS Super Resolution (SR)

SR mejora el rendimiento utilizando inteligencia artificial para derivar fotogramas de mayor resolución a partir de fotogramas de menor resolución. DLSS selecciona varias imágenes de menor resolución y utiliza datos de movimiento y retroalimentación de fotogramas anteriores para crear imágenes de alta calidad. El producto final del modelo Transformer es más estable en el tiempo, con menos halos, más detalles en movimiento y un antialiasing mejorado que las versiones anteriores de DLSS.

Imagen №12. Un ejemplo de superresolución. Autor: Nvidia.

Imagen №12. Un ejemplo de superresolución. Autor: Nvidia.

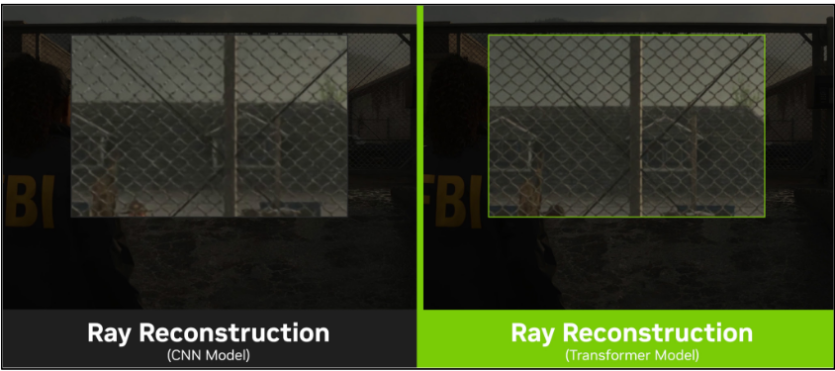

DLSS Ray Reconstraction (RR)

RR mejora la calidad de imagen utilizando la inteligencia artificial para crear píxeles adicionales en las escenas de trazado de rayos intensos. DLSS sustituye la reducción manual del ruido por una red de IA entrenada por un superordenador NVIDIA que genera píxeles de mayor calidad entre los rayos muestreados. En contenidos con trazado de rayos intenso, el modelo Transformer for RR obtiene un aumento de calidad aún mayor, especialmente en escenas con iluminación compleja. De hecho, se reducen significativamente todos los artefactos habituales de los motores típicos de reducción de ruido.

Imagen №13. Un ejemplo de Reconstrucción de Rayos. Autor: Nvidia.

Imagen №13. Un ejemplo de Reconstrucción de Rayos. Autor: Nvidia.

Deep Learning Anti-Aliasing (DLAA)

DLAA ofrece una calidad de imagen superior gracias a la tecnología antialiasing basada en IA. DLAA utiliza la misma tecnología Super Resolution desarrollada para DLSS, creando una imagen más realista y de alta calidad en su resolución original

Y no olvides venir a leer Visión general de la RTX 5080!

Autor: NVIDIA.

Spelling error report

The following text will be sent to our editors: