Durante mucho tiempo se ha debatido activamente la búsqueda de una arquitectura mejor para los grandes modelos lingüísticos (LLM) que pudiera convertirse en una alternativa a los transformadores. Parece que la startup californiana Inception Labs ya tiene una solución prometedora. La empresa ha presentado Mercury, el primer gran modelo lingüístico del mundo basado en la difusión y diseñado para uso comercial.

Según la plataforma de pruebas independiente Artificial Analysis, Mercury es 10 veces más rápido que los modelos avanzados actuales. Su rendimiento supera los 1.000 tokens por segundo en las GPU NVIDIA H100, algo que antes sólo era posible en chips especializados.

¿Cómo funciona?

«Los transformadores dominan la generación de texto LLM y crean tokens secuencialmente. Los modelos de difusión ofrecen una alternativa: generan todo el texto simultáneamente, aplicando un proceso de grueso a fino»», explicó Andrew En, fundador de DeepLearning.AI, en su post sobre X.

Esta última frase es clave para entender por qué el enfoque de Inception Labs parece interesante. En pocas palabras, los LLM basados en transformadores aprenden de forma autorregresiva, lo que significa que predicen palabras (o tokens) de izquierda a derecha. Sin embargo, la difusión es una técnica que la inteligencia artificial suele utilizar para generar imágenes y vídeos. La difusión funciona de forma diferente: no se mueve de izquierda a derecha, sino que crea todo el texto a la vez. En este caso, todo empieza con «ruido», que se va limpiando poco a poco y se obtiene un flujo de tokens.

Mercury puede cambiar las reglas del juego y abrir nuevas oportunidades para los LLM. Y según las pruebas realizadas, este enfoque afecta significativamente a la velocidad de generación de texto.

Velocidad y rendimiento Mercury

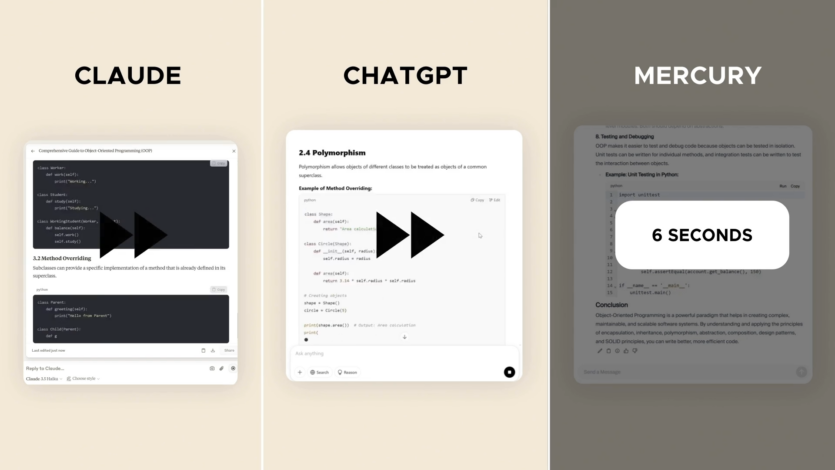

En las pruebas de codificación estándar, Mercury superó a modelos de alta velocidad como GPT-4o Mini, Gemini 2.0 Flash y Claude 3.5 Haiku.

En concreto, la versión Mercury Coder Mini alcanzó 1109 tokens por segundo.

.

Además, la startup afirmó que los modelos de difusión tienen ventaja en el pensamiento lógico y las respuestas estructuradas, ya que no se limitan únicamente a los tokens anteriores.

.

Además, pueden mejorar continuamente la salida, reduciendo las alucinaciones y los errores. Son métodos de difusión que se utilizan en generadores de vídeo como Sora y Midjourney.

La empresa también criticó los métodos de inferencia lógica más avanzados, que requieren importantes recursos informáticos para generar respuestas complejas.

«La creación de largas cadenas lógicas conlleva enormes costes de computación y una latencia inaceptable. Es necesario un cambio de paradigma para que la inteligencia artificial de alta calidad sea asequible», afirman desde Inception Labs.

La startup ha lanzado una versión preliminar de Mercury Coder para ayudar a los usuarios a podría probar sus capacidades.

Hace pocoAnthropic presenta Claude 3.7 Soneto — el primer modelo de razonamiento híbrido y «la mejor IA para informáticos».

Fuente: analyticsindiamag

Spelling error report

The following text will be sent to our editors: