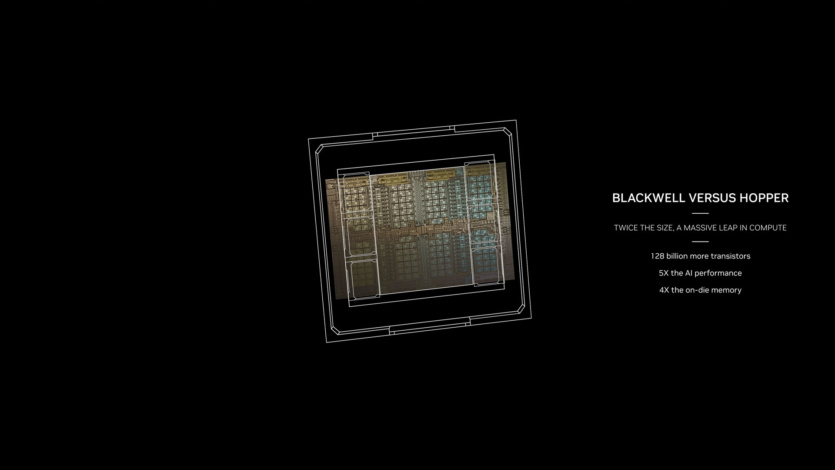

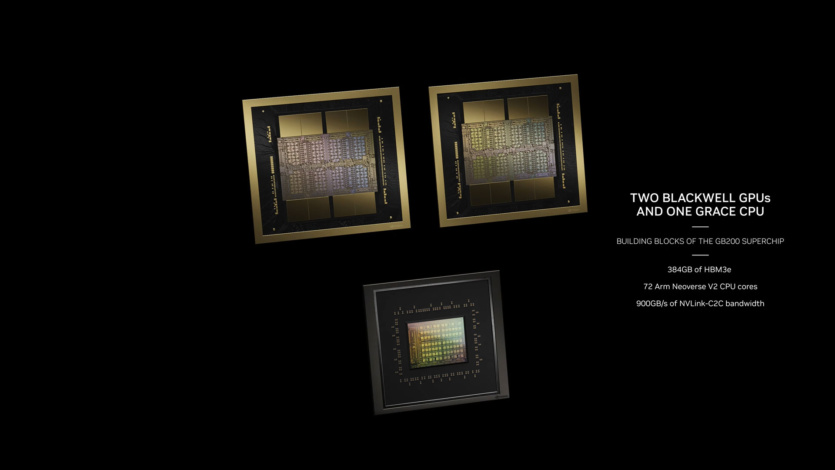

En la keynote de la GTC de marzo de 2024, NVIDIA presentó la arquitectura de chip Blackwell y las GPU B200 basadas en ella. Las nuevas GPU con funciones de inteligencia artificial sustituirán a las H100 y H200 en los centros de datos. Los chips Grace Blackwell GB200 combinarán la arquitectura Grace con Blackwell.

La GPU B200 contiene 208.000 millones de transistores (frente a los 80.000 millones de la H100/H200). Ofrece 20 petaflops de rendimiento de IA desde una sola GPU — una sola H100 tenía un máximo de 4 petaflops de cálculo de IA. Los chips tendrán 192 GB de memoria HBM3e, que proporciona hasta 8 TB/s de ancho de banda.

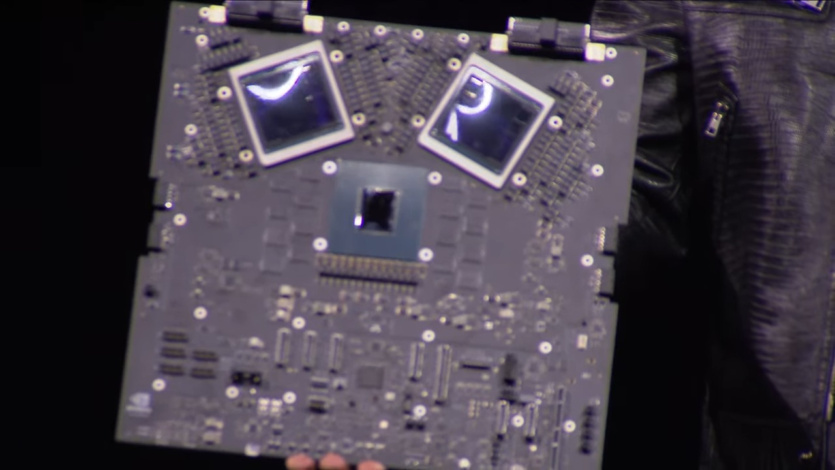

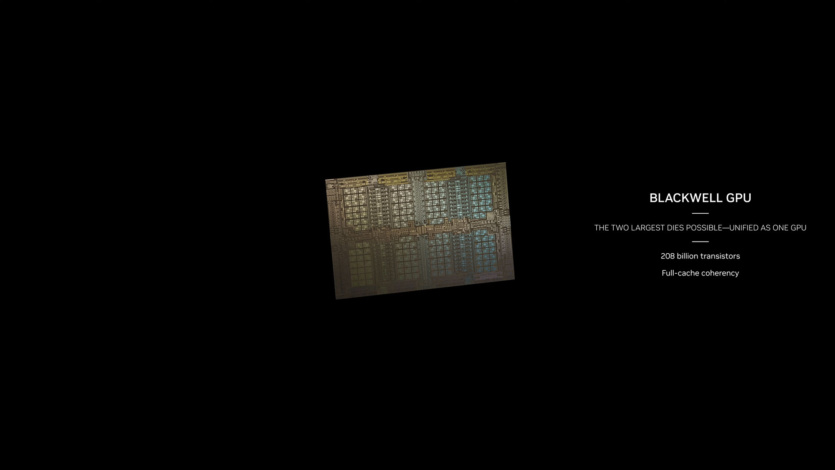

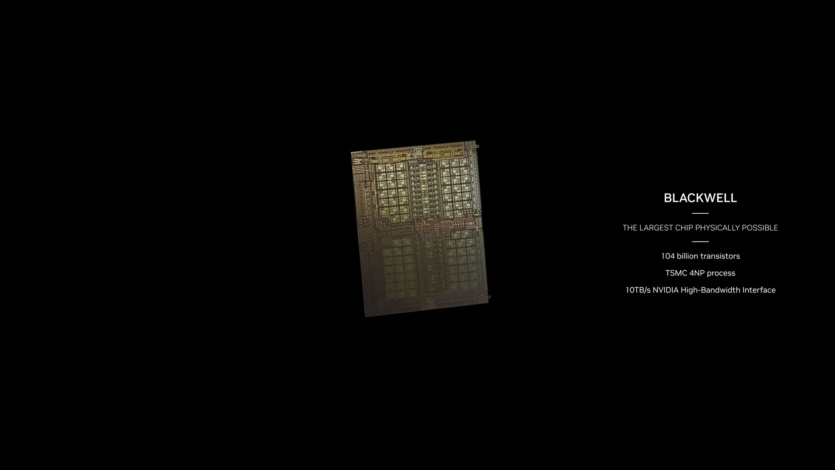

Blackwell B200 no es una única GPU en el sentido tradicional. Consta de dos chips estrechamente conectados que funcionan como una GPU CUDA unificada. Los dos chips están conectados por una interfaz NV-HBI (NVIDIA High Bandwidth Interface) con una velocidad de 10 TB/s.

El Blackwell B200 se basa en el proceso 4NP de TSMC, una mejora del proceso 4N utilizado en el Hopper H100 y el Ada Lovelace. El proceso no ofrece grandes mejoras de densidad, por lo que se necesitaba una forma de hacer el chip más grande para ganar potencia de procesamiento, lo que puede explicar la combinación.

Cada chip tiene cuatro pilas HMB3e de 24 GB cada una con 1 TB/s de ancho de banda en una interfaz de 1024 bits. A modo de comparación, el H100 tenía seis pilas HBM3 de 16 GB. El Blackwell B200 alcanza 20 petaflops utilizando el nuevo formato numérico FP4 con el doble de ancho de banda que el formato FP8 del Hopper H100.

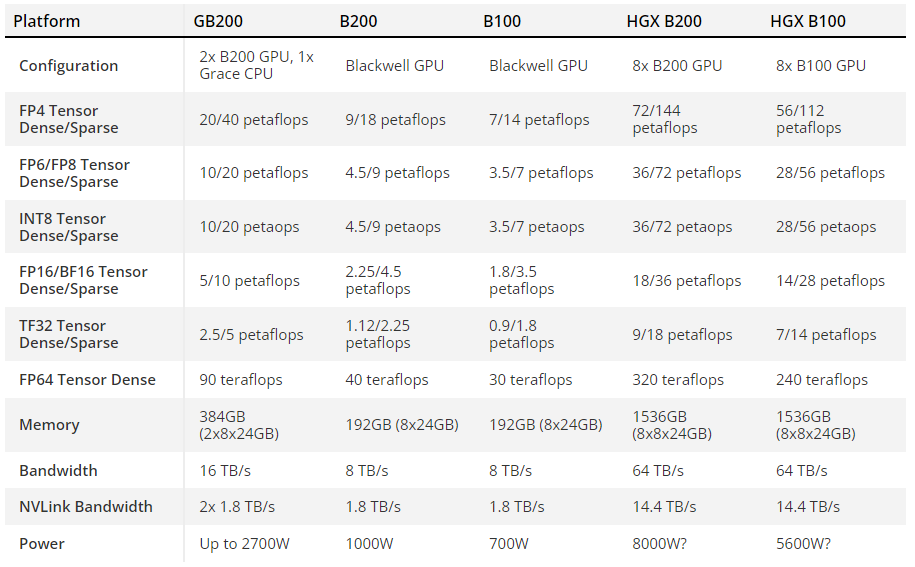

Variantes del chip NVIDIA Blackwel

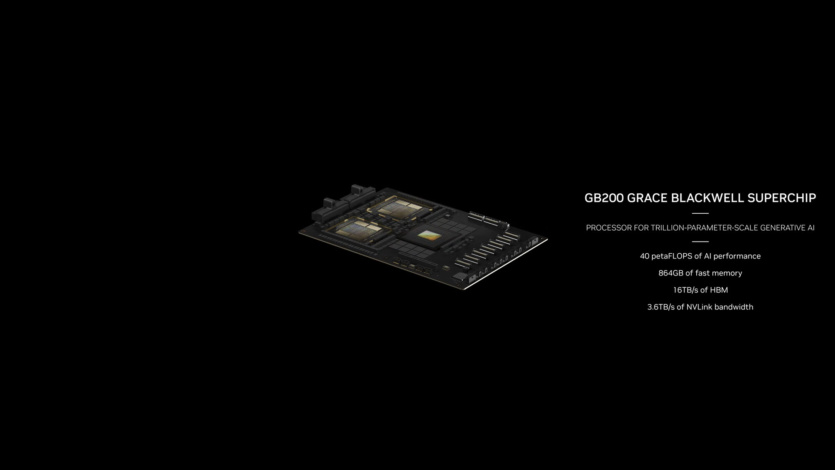

La solución más grande y rápida es el superchip GB200, formado por dos GPU B200. Este «monstruo» tiene un TDP sintonizable de hasta 2700W — para dos chips (cuatro GPU combinadas) más un procesador Grace. Los valores de hasta 20 petaflops FP4 para un solo B200 — se toman para la mitad del superchip GB200. No se especifica cuál es el TDP para una sola GPU B200.

Otra opción de Blackwell es la HGX B200, que se basa en el uso de ocho GPU x86 en un único nodo de servidor. Están configurados con 1000W por B200 y las GPUs proporcionan hasta 18 petaflops de rendimiento FP4 — 10% más lento que GB200.

También habrá un chip HGX B100. Tiene el mismo diseño básico que el HGX B200, con un procesador x86 y ocho GPU B100, pero está diseñado para ser compatible con la infraestructura HGX H100 existente y proporcionar el despliegue más rápido. El TDP por GPU se limita a 700 W, el mismo que el de la H100, y el rendimiento se reduce a 14 petaflops FP4 por GPU. En las tres configuraciones, la GPU HBM3e ofrece el mismo rendimiento de 8 TB/s.

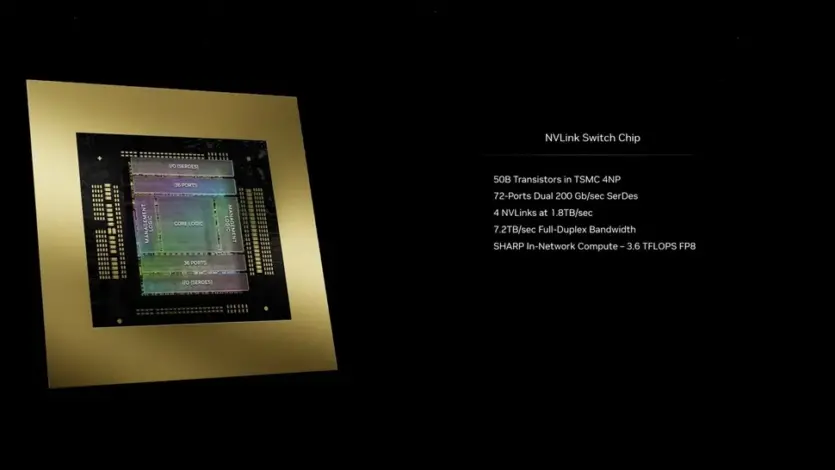

NVIDIA NVLINK 7.2T

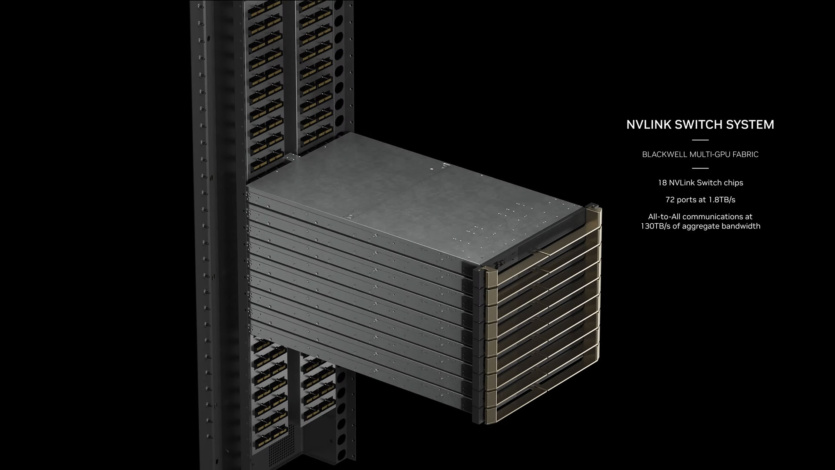

Para la conectividad multinodo, NVIDIA presenta la quinta generación de chips NVLink y el NVLink Switch 7.2T. El nuevo chip NVSwitch tiene un ancho de banda bidireccional de 1,8 TB/s. Se trata de un chip de 50.000 millones de transistores, fabricado también en el proceso 4NP de TSMC.

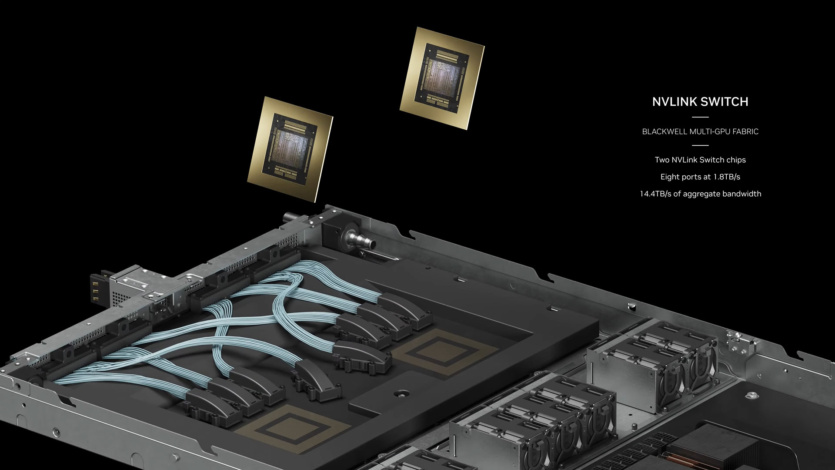

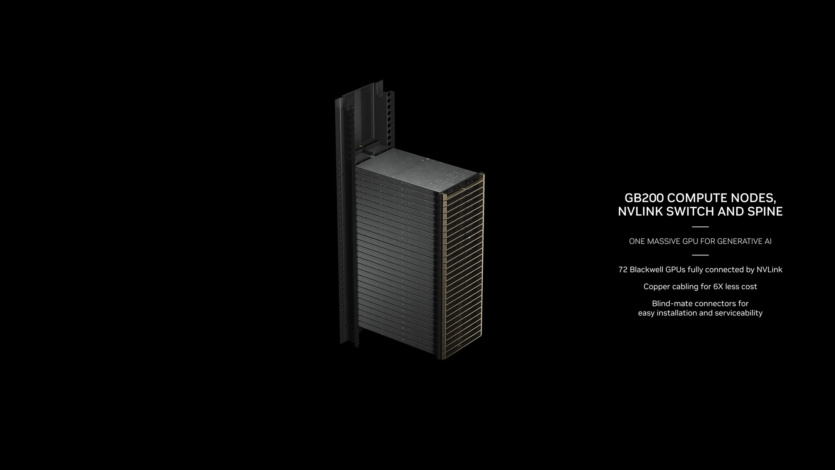

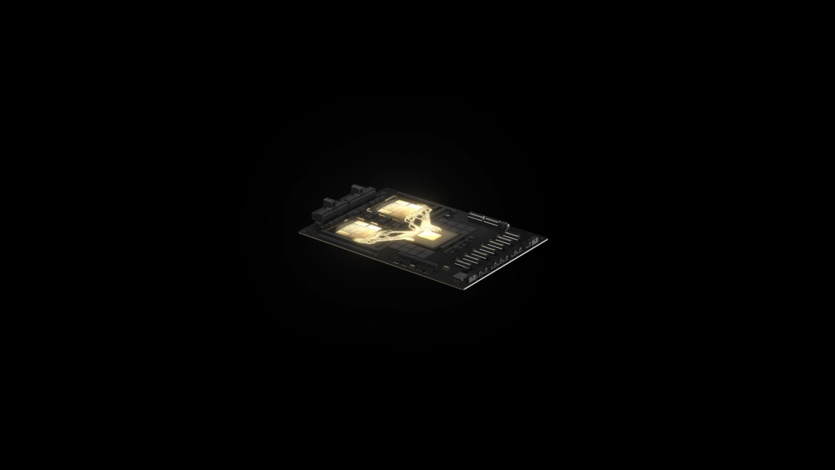

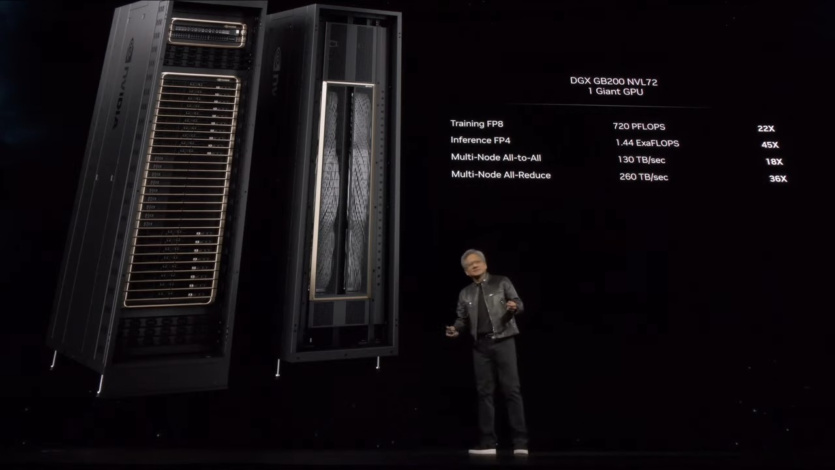

Cada nodo de cálculo del GB200 NVL72 tiene dos superchips GB200, por lo que una bandeja contiene dos CPU Grace y cuatro GPU B200 con un rendimiento de 80 petaflops FP4 AI y 40 petaflops FP8 AI. Se trata de servidores de 1U con refrigeración líquida que ocupan una parte significativa de las 42 unidades de rack estándar.

Además de los paneles de supercomputación GB200, el GB200 NVL72 también tendrá paneles de conmutación NVLink. Se trata también de bandejas 1U con refrigeración líquida, con dos conmutadores NVLink por bandeja y nueve bandejas por rack. Cada bandeja proporciona 14,4 TB/s de ancho de banda total.

El GB200 NVL72 tiene un total de 36 procesadores Grace y 72 GPU Blackwell con 720 petaflops FP8 y 1440 petaflops FP4. Con 130 TB/s de ancho de banda multinodo, el NVL72 puede manejar hasta 27 billones de parámetros de modelos de lenguaje de IA. Los racks restantes están dedicados a redes y otros elementos del centro de datos.

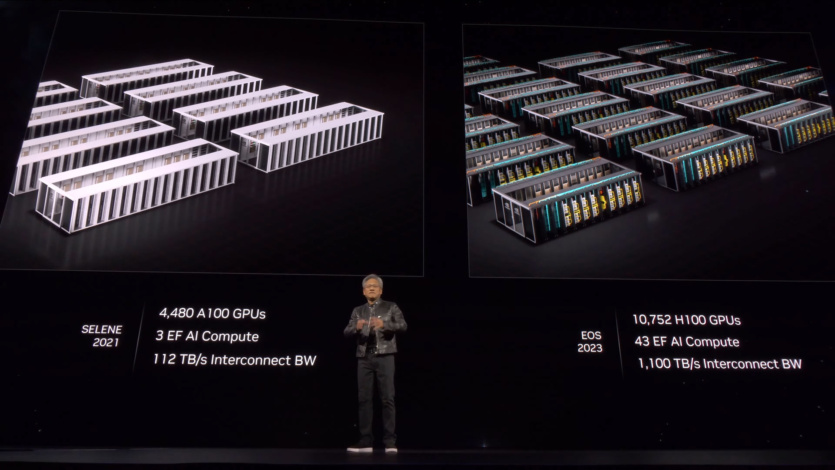

También se han introducido los SuperPOD, que combinan múltiples GB200. Ahora que NVLink admite hasta 576 dominios de GPU, los nuevos SuperPODs de DGX se adaptan exactamente a ese número de GPUs Blackwell GB200. Cada SuperPOD puede alojar hasta ocho sistemas GB200 NVL72, lo que corresponde a 288 procesadores Grace y 576 GPU B200.

Fuente: Tom’s Hardware