Люди все чаще используют чат-боты ИИ для получения советов в любви или психологии. Однако иногда общение с сервисами искусственного интеллекта имеет плохие последствия для психического здоровья. OpenAI решила обновить ChatGPT, чтобы он лучше распознавал признаки психоэмоциональной нестабильности и предоставлял полезные советы в сложных ситуациях.

Компания сотрудничает со специалистами по психическому здоровью и консультативными группами, чтобы сделать ответы чат-бота более обоснованными и безопасными, в частности — когда речь идет о тревожных или кризисных состояниях.

Потребность в таких изменениях возникла после ряда публикаций о случаях, когда ChatGPT не только не помогал людям в уязвимом состоянии, но и непреднамеренно углублял их иллюзии или эмоциональную зависимость. Например, в апреле компания отменила обновление, из-за которого чат-бот начал слишком часто соглашаться с пользователями даже в рискованных темах. Тогда OpenAI признала, что чрезмерная «податливость» чат-бота может вызвать беспокойство и навредить.

Компания признается, что GPT-4o не всегда вовремя распознавал признаки дезориентации или эмоциональной зависимости. Это может создать ложное впечатление о понимании и поддержке со стороны ИИ, особенно у уязвимых пользователей. Именно поэтому новые изменения ориентированы на то, чтобы ChatGPT в случае необходимости предоставлял проверенную информацию и ресурсы для психологической поддержки.

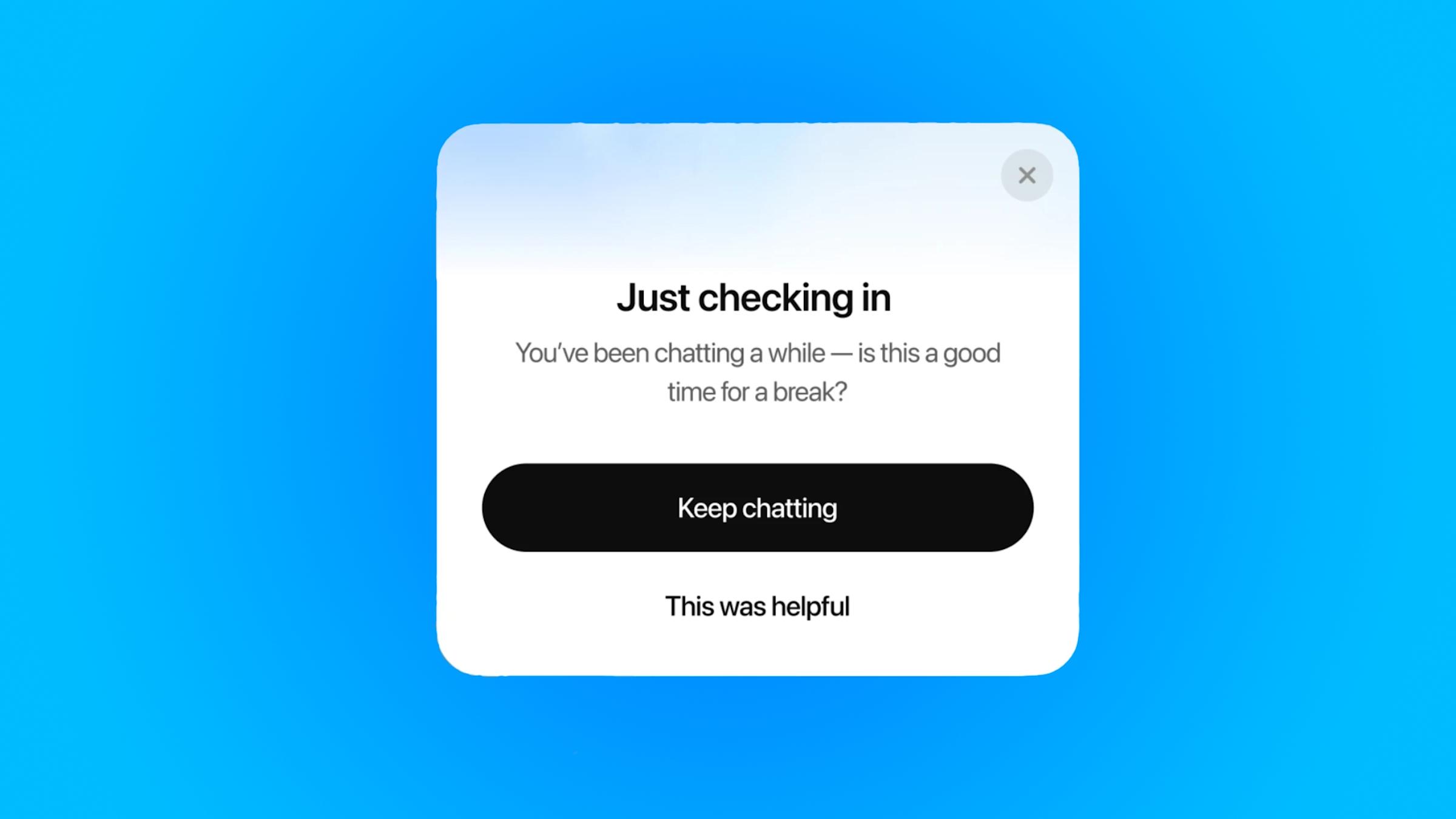

Чтобы пользователи не истощались во время длительных сессий общения с ботом, OpenAI добавляет новую функцию — напоминание о перерыве. Если вы слишком долго общаетесь с ChatGPT, появится сообщение вроде: «Вы уже долго разговариваете — возможно, время на перерыв?», после чего можно либо продолжить чат, либо завершить разговор. OpenAI отмечает, что и в дальнейшем будет совершенствовать алгоритмы появления таких уведомлений.

Похожие функции уже давно используют YouTube, Instagram, TikTok, Xbox и другие платформы. Например, платформа Character.AI ввела систему оповещения родителей, если их дети ведут диалоги с потенциально опасными ботами. Это стало ответом на судебные иски, которые обвиняли компанию в том, что чат-боты поощряли к самоповреждению.

Еще одно изменение, которое появится в ближайшее время, — осторожность в ответах на чувствительные запросы. Теперь, когда пользователь спросит что-то вроде «Стоит ли мне расстаться с партнером?», ChatGPT не будет давать прямой совет, а поможет обдумать возможные варианты и их последствия.

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: