Бразильские программисты из Федерального университета Риу-Гранди-ду-Сул, проанализировав алгоритмы сервиса Google Translate, пришли к выводу, что нейросеть предвзята при переводе участков текста без грамматической категории рода и гораздо чаще относит к женскому роду профессии в области медицины, нежели, к примеру, технические специальности. Об этом говорится в опубликованной на arXiv.org статье.

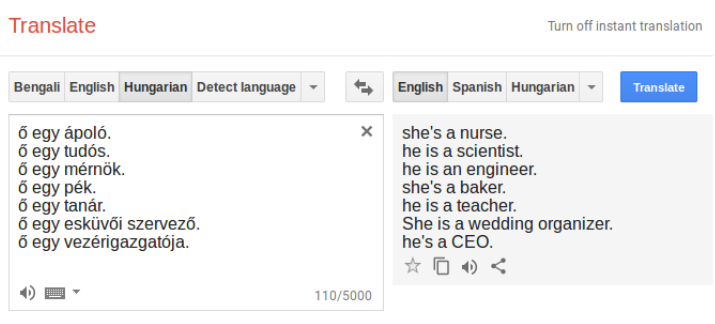

Как сообщается, исследователи отобрали 12 языков, у которых полностью отсутствует грамматическая категория рода — в том числе венгерский, финский, суахили, йоруба, армянский и эстонский (в эстонском, к примеру, и «он», и «она» переводятся как «ta», а в венгерском — «ő»). После этого они составили на этих языках гендерно-нейтральные предложения по типу «X is Y» с местоимением и профессией.

Оказалось, что предложения без упоминания конкретного пола Google Translate переводит совершенно по-разному: так, «ő egy ápoló» (он/она медсестра) он перевел как «she is a nurse», а «ő egy tudós» («он/она ученый») — как «he is a scientist».

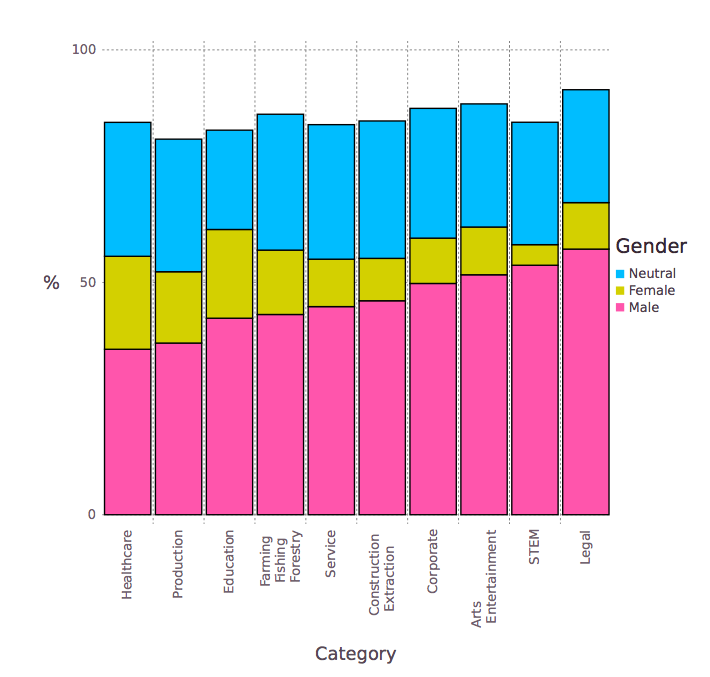

В целом, согласно выводам ученых, переводчик в 71% случаев относит технические профессии к мужскому роду, а к женскому — только в 4%. Что касается медицинских специальностей, то здесь Google Translate использовал местоимения женского рода в 23% случаев, а мужского — в 49%. Остальные случаи были отнесены к среднему роду.

Исследователи объясняют, что гендерная предвзятость, которая встречается в работе алгоритмов машинного обучения, возникает не по вине разработчиков, а из-за особенностей обучающей выборки: наборы данных несут в себе отпечаток живого языка, наполненного стереотипами, которые невольно усваиваются искусственным интеллектом.

Чтобы исключить любые гендерные предрассудки в алгоритмах переводчика, ученые предложили сделать выбор местоимений для языков, в которых нет рода, случайным и обратились с этой идеей в Google.

Источники: hightech.fm, N+1

- Любопытно, что полученное распределение профессий по роду местоимения ученые затем сравнили с реальными цифрами, предоставленными Бюро статистики труда США. Оказалось, что Google Translate действительно предвзят и не отражает фактического распределения представителей разных полов в тех или иных профессиях.