Люди все частіше використовують ШІ-чатботи для отримання порад у коханні чи психології. Однак інколи спілкування с сервісами штучного інтелекту має погані наслідки для психічного здоров’я. OpenAI вирішила оновити ChatGPT, щоб він краще розпізнавав ознаки психоемоційної нестабільності та надавав корисні поради у складних ситуаціях.

Компанія співпрацює з фахівцями з психічного здоров’я та консультативними групами, щоб зробити відповіді чат-бота обґрунтованішими й безпечнішими, зокрема — коли йдеться про тривожні або кризові стани.

Потреба в таких змінах виникла після низки публікацій про випадки, коли ChatGPT не лише не допомагав людям у вразливому стані, а й ненавмисно поглиблював їхні ілюзії або емоційну залежність. Наприклад, у квітні компанія скасувала оновлення, через яке чатбот почав занадто часто погоджуватися з користувачами навіть у ризикованих темах. Тоді OpenAI визнала, що надмірна «піддатливість» чат-бота може викликати занепокоєння та шкодити.

Компанія зізнається, що GPT-4o не завжди вчасно розпізнавав ознаки дезорієнтації або емоційної залежності. Це може створити хибне враження про розуміння та підтримку з боку ШІ, особливо у вразливих користувачів. Саме тому нові зміни орієнтовані на те, щоб ChatGPT у разі потреби надавав перевірену інформацію й ресурси для психологічної підтримки.

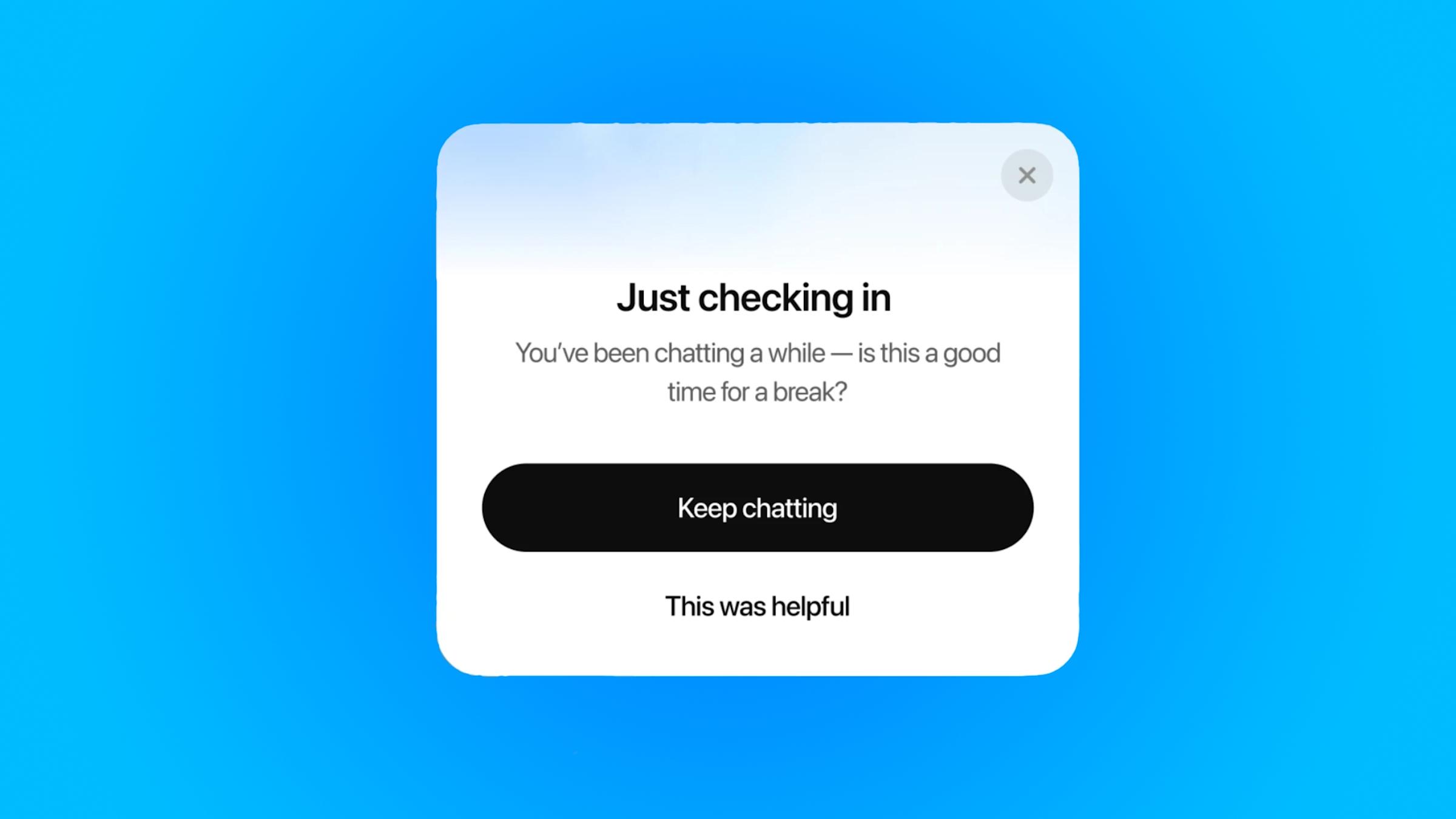

Щоб користувачі не виснажувалися під час тривалих сесій спілкування з ботом, OpenAI додає нову функцію — нагадування про перерву. Якщо ви занадто довго розмовляєте з ChatGPT, з’явиться повідомлення на кшталт: “Ви вже довго розмовляєте — можливо, час на перерву?”, після чого можна або продовжити чат, або завершити розмову. OpenAI зазначає, що й надалі вдосконалюватиме алгоритми появи таких сповіщень.

Схожі функції вже давно використовують YouTube, Instagram, TikTok, Xbox та інші платформи. Наприклад, платформа Character.AI запровадила систему сповіщення батьків, якщо їхні діти ведуть діалоги із потенційно небезпечними ботами. Це стало відповіддю на судові позови, які звинувачували компанію в тому, що чат-боти заохочували до самопошкодження.

Ще одна зміна, яка з’явиться найближчим часом, — обережність у відповідях на чутливі запити. Тепер, коли користувач запитає щось на кшталт “Чи варто мені розлучитися з партнером?”, ChatGPT не даватиме прямої поради, а допомагатиме обміркувати можливі варіанти та їхні наслідки.

Коли ChatGPT зводить з глузду — OpenAI найняла психіатра, щоб стежити за цим

Повідомити про помилку

Текст, який буде надіслано нашим редакторам: