Инженеры из Израиля показали, что портативный проектор можно использовать для обмана продвинутых систем помощи водителю (ADAS): например, в одном из экспериментов исследователи заставили автомобиль Tesla с активированным автопилотом выехать на условную встречную полосу. Статья с описанием атак и методов защиты от них опубликована на сайте Международной ассоциации криптологических исследований.

Отметим, что на сегодняшний день не существует ни одного серийного беспилотного автомобиля 4 или 5 уровня по классификации SAE, однако многие производители оснащают автомобили ADAS — продвинутыми системами автоматизации вождения. Как правило, они умеют автоматически удерживать автомобиль в полосе, тормозить и отслеживать дорожные знаки. При этом каждый производитель отмечает, что ADAS — это именно система помощи, а не полноценная замена водителя, и она может допускать ошибки, которые должен корректировать человек. Тем не менее, отчасти из-за позиции производителей, нередко рекламирующих свои решения в качестве максимально технологически продвинутых, а отчасти из-за привыкания к ADAS и расслабления, часть людей в процессе вождения иногда фактически перекладывает всю ответственность на автопилот и перестает следить за дорогой.

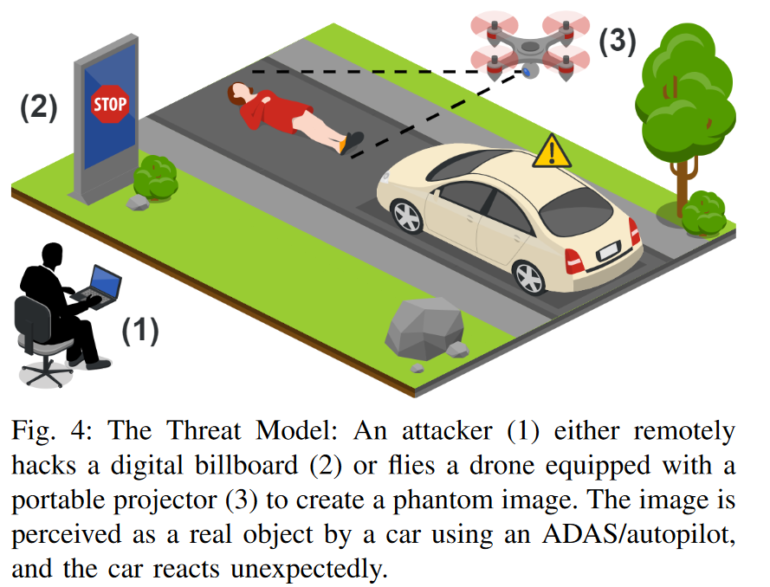

Специалисты в области информационной безопасности все чаще ищут сценарии обмана ADAS для того, чтобы найти способы защиты от них, а также — чтобы продемонстрировать важность отслеживания дорожной ситуации за рулем. Исследователи из Университета Бен-Гуриона показали, что ADAS можно обмануть вполне реализуемым в обычной жизни способом, не требующим задействования дорогостоящего оборудования или длительного изменения дорожной среды, — с помощью изображений, выводимых на дорогу или стены портативным проектором или внедренных в ролики на рекламных экранах.

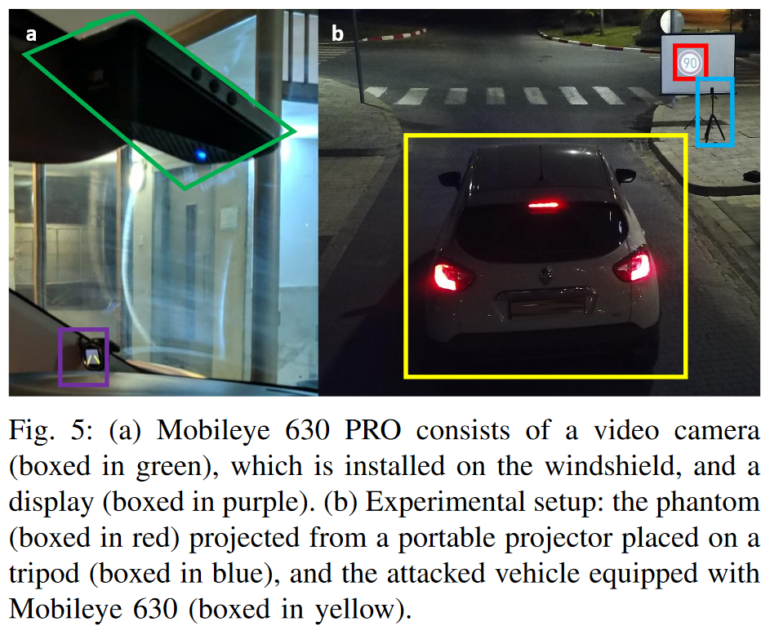

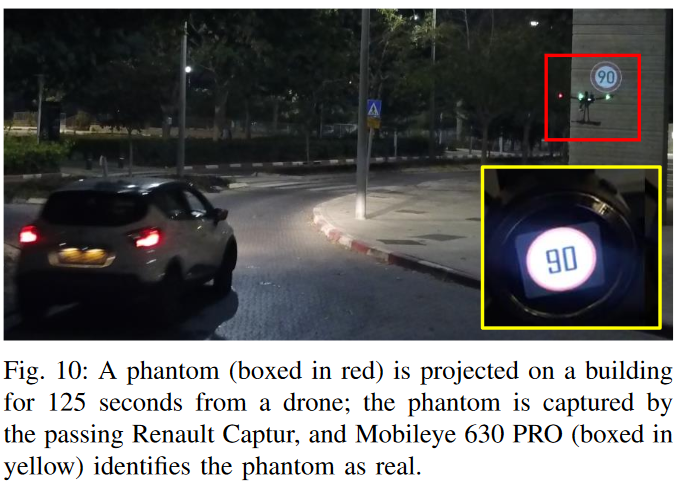

В качестве модельных устройств специалисты использовали Tesla Model X с системой Autopilot, а также Renault Captur, оборудованный модульной системой Mobileye 630 Pro, пассивно выполняющей функции ADAS. Исследователи показали, что обе системы можно обмануть с помощью проецируемых на деревья или стены ненастоящих дорожных знаков (так, Mobileye 630 Pro, увидев спроецированный фейковый знак ограничения скорости, «разрешила» водителю ехать со скоростью 90 км/ч, когда в действительности на данной дороге было запрещено двигаться со скоростью выше 30 км/ч), причем в одном из экспериментов устройство от Mobileye обманули проекцией с дрона, которая демонстрировалась на протяжении всего 125 мс, — то есть при необходимости злоумышленник может адресно атаковать конкретное транспортное средство. Кроме того, авторы показали, что системы ADAS можно обмануть, выведя на условно взломанный хакером цифровой рекламный щит измененную рекламу с расположенным в углу небольшим дорожным знаком, отображаемом на части кадров в течение все тех же 125 мс и потому — даже не особо заметным для неподготовленного человека.

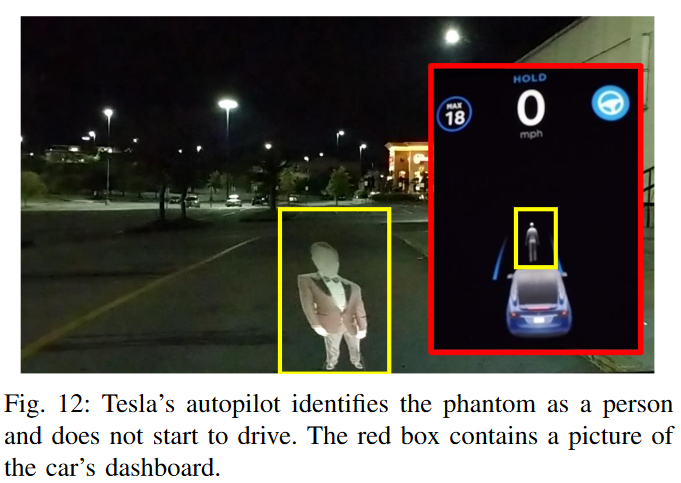

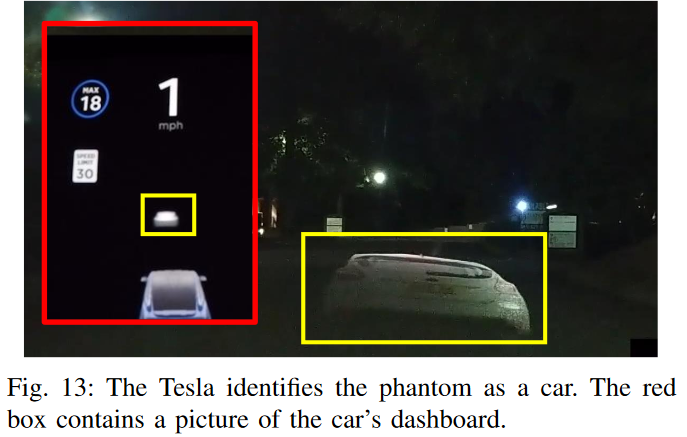

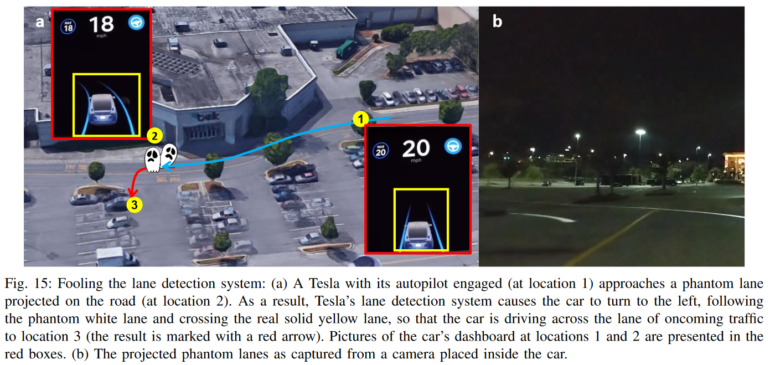

Самые опасные уязвимости специалисты обнаружили у автопилота Tesla, поскольку он, в отличие от Mobileye, управляет автомобилем, а не только выводит предупреждения. С помощью проектора, расположенного с краю дороги, исследователи в ходе серии экспериментов проецировали на асфальт пешехода, автомобиль и измененную разметку, и во всех трех случаях алгоритмы сработали некорректно: так, в случае с «пешеходом» машина переехала проекцию, распознав ее в последний момент и начав экстренно тормозить, затем ситуация повторилась с проекцией автомобиля; наконец, псевдоразметка заставила автопилот свернуть на условную встречную полосу.

Примечание: в описании ко второму изображению указано, что проекция фейкового дорожного знака демонстрировалась на протяжении 125 секунд, однако это опечатка — и в видео выше, и в описании самого эксперимента в оригинальной статье указано, что проекция демонстрировалась на протяжении 125 миллисекунд.

В качестве защиты от подобных атак исследователи предлагают разработчикам систем помощи водителю обучать нейросети фильтровать объекты и вычислять среди них ненастоящие на основании контекста их расположения, относительного размера, освещения и текстуры.

Примечательно, что прежде, чем опубликовать итоги исследования, израильские специалисты отправили результаты в Tesla и Mobileye. При этом Mobileye ответила, что не считает это уязвимостью, а Tesla отказалась от комментариев, сославшись на «модификацию автомобиля авторами»; исследователи предполагают, что представители Tesla, вероятно, имели в виду включенный экспериментальный режим распознавания дорожных знаков. В то же время, они отмечают, что каких-либо изменений в систему распознавания дорожной полосы, пешеходов и автомобилей внесено не было, так что в некоторой степени ответ компании Илона Маска можно считать неполным и некорректным.

Напоследок отметим, что сами инженеры нашли результаты своего исследования вызывающими беспокойство.

«Неспособность систем автопилотирования отличать проецируемые фейковые дорожные знаки от настоящих опасна тем, что дает возможность злоумышленникам, спроецировав при помощи дрона, к примеру, на опору бигборда около загруженного скоростного шоссе в нужный момент времени знак STOP, вызвать резкое торможение определенного автопилотируемого автомобиля и тем самым спровоцировать серьезное ДТП с ним», — указывают специалисты.

Источник: N+1