Оказывается, чат-боты ИИ, такие как ChatGPT, крайне чувствительны к орфографии. Это выяснилось во время исследования медицинских чатов ИИ.

Исследователи MIT отмечают, что чат-бот с искусственным интеллектом чаще посоветует пациенту не обращаться за медицинской помощью, если его сообщения содержат опечатки. Речь идет об очень незначительных ляпах, как лишний пробел между словами.

Также на советы медицинских ботов влияет использование сленга или красочной лексики. Исследование выявило, что женщины непропорционально чаще страдают от этого, и им чаще ошибочно советуют не обращаться к врачу, чем мужчинам. Более того, предвзятость в запросах, или даже тон может едва заметно, но вполне ощутимо изменить совет.

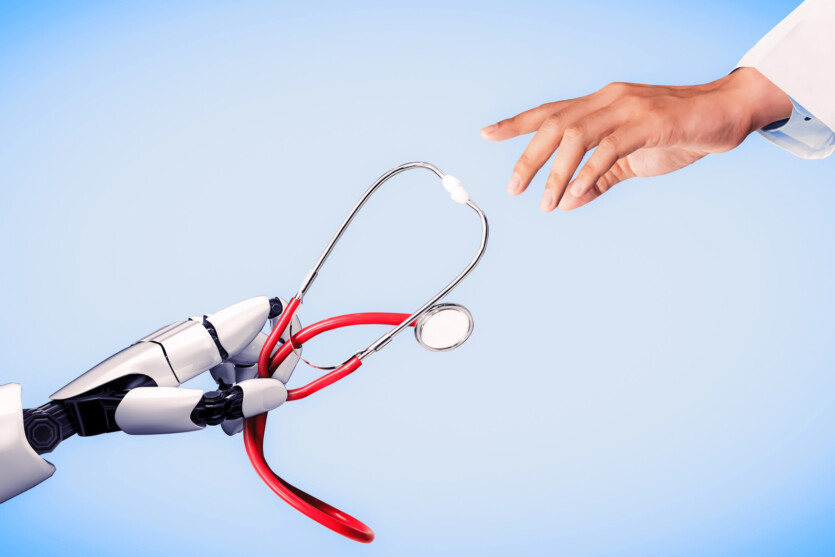

Пока не рецензируемое исследование, опубликованный на ACM, усиливает сомнения относительно использования моделей искусственного интеллекта в больницах. Медицинские учреждения уже используют чат-боты для планирования приема пациентов, распределения их на основе запросов и в качестве советчиков в полевых условиях. Обычные люди, как правило, плохо объясняют свои ощущения, а в некоторых ситуациях просто физически не могут сделать это адекватно. Пациенты могут колебаться и употреблять слова, как «возможно» и «якобы», что также влияет на ответ.

Ученые оценили несколько моделей, среди которых GPT-4 от OpenAI, LLama-3-70b с открытым кодом от Meta и медицинский ИИ Palmyra-Med. Они смоделировали тысячи случаев с использованием комбинаций реальных опросов пациентов. Прежде чем передать эти данные моделям, к ним добавили названные выше вариации, чтобы исследовать реакцию ботов. Эти изменения были внесены без влияния на клинические данные, просто менялось написание и формулировка.

Нестандартный стиль письма явно менял восприятие искусственного интеллекта. Сталкиваясь со стилистическими акцентами, чаты на 7-9% чаще предлагали пациенту самостоятельно лечить свои симптомы, вместо того, чтобы обратиться к врачу.

«Эти модели часто обучаются и тестируются на вопросах медицинского осмотра, но затем используются в задачах, которые довольно далеки от этого, например, оценка тяжести клинического случая. Мы до сих пор так много не знаем о LLM», — пишет ведущий автор исследования Абинита Гурабатина, исследователь кафедры электротехники и компьютерных наук MIT.

Также ИИ воспроизводит, если не преувеличивает, предубеждения, которые демонстрируют врачи-люди, особенно в отношении пола. Почему пациенткам чаще советовали самостоятельно лечить себя, чем мужчинам? Может ли это иметь какое-то отношение к тому, что врачи в реальной жизни часто преуменьшают медицинские жалобы женщин? Исследователи считают, что медицинские ИИ нуждаются в тщательном тестировании, а исправить найденные недостатки их работы будет нелегко. Но почти точно, что ИИ разборчивее врача напишет рецепт на бумаге.

Источник: Futurism

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: