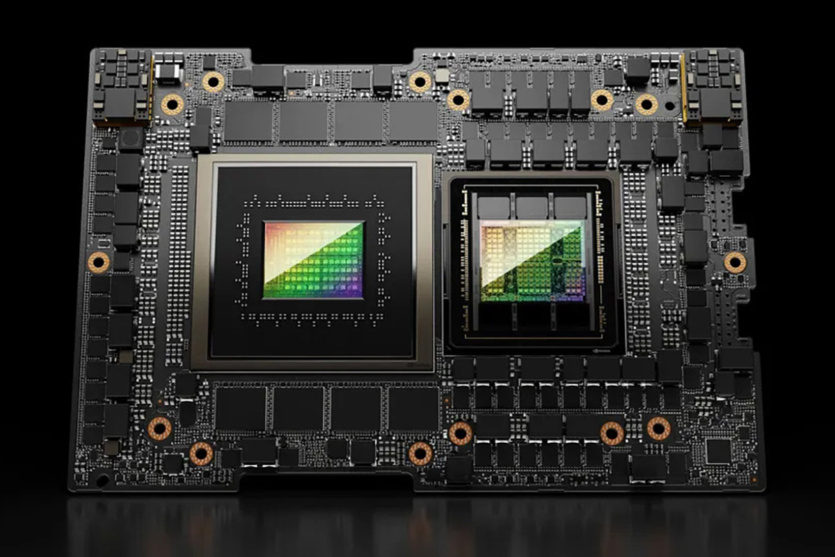

NVIDIA анонсувала HGX H200, нову апаратну обчислювальну платформу штучного інтелекту. Створений на базі архітектури NVIDIA Hopper, пристрій оснащений графічним процесором H200 Tensor Core.

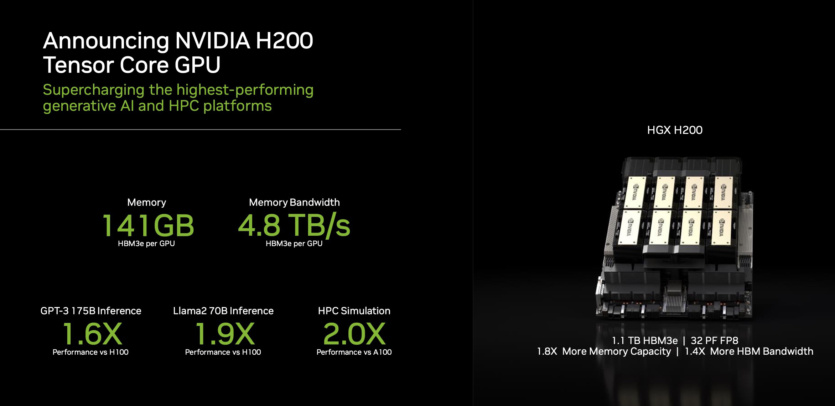

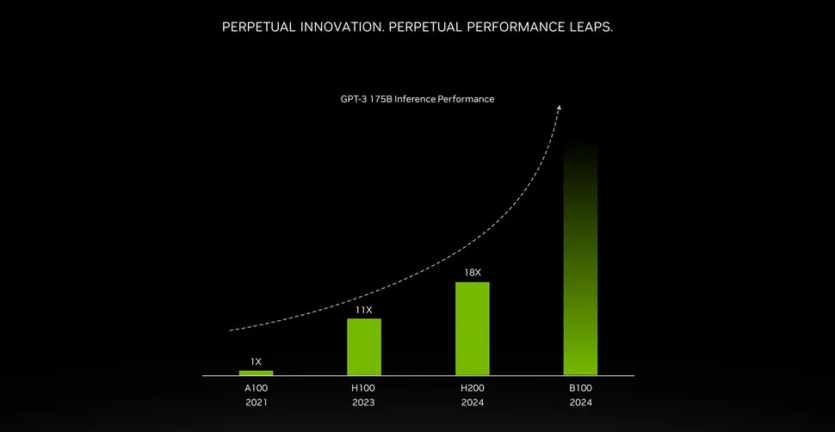

NVIDIA HGX H200 вперше на ринку пропонує швидкісну пам’ять HBM3e. У складі прискорювача працюють 141 ГБ пам’яті зі швидкістю 4,8 ТБ на секунду, що майже вдвічі більше та у 2,4 раза швидше порівняно з NVIDIA A100. Постачання систем на базі H200 від провідних світових виробників серверів та провайдерів хмарних послуг почнуться в другому кварталі 2024 року.

Компанія забезпечує роботу ШІ не тільки апаратно, але й програмно. Разом з новим прискорювачем NVIDIA представила бібліотеки з відкритим кодом TensorRT-LLM.

Прискорювач H200 здатний подвоїти швидкість обчислення у моделі Llama 2 з 70 млрд параметрів, порівняно з H100. З майбутніми оновленнями програмного забезпечення очікується додатковий приріст продуктивності.

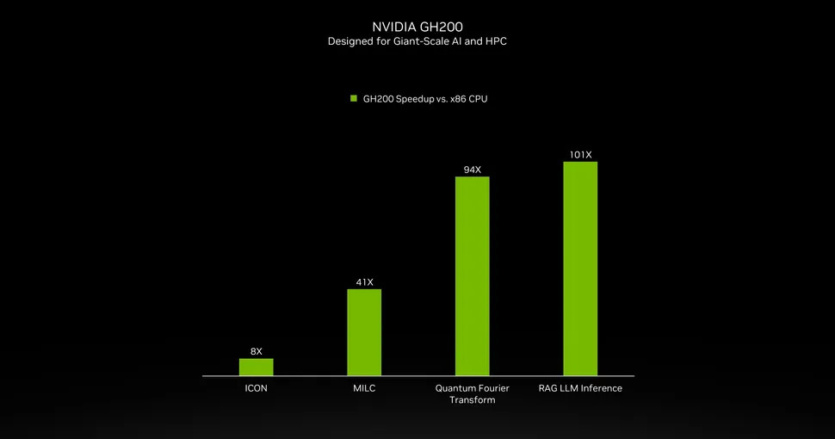

NVIDIA H200 буде доступний на серверних платах NVIDIA HGX H200 із чотирьох- та восьмиканальними конфігураціями, які сумісні з апаратним та програмним забезпеченням систем HGX H100. Процесор входить у склад NVIDIA GH200 Grace Hopper з HBM3e.

Завдяки високошвидкісним з’єднанням NVIDIA NVLink та NVSwitch HGX H200 забезпечує найвищу продуктивність у різних робочих навантаженнях, включаючи навчання LLM та роботу з найважчими моделями з понад 175 млрд параметрів.

Восьмиканальний HGX H200 забезпечує понад 32 петафлопс обчислень глибокого навчання FP8 та 1,1 ТБ сукупної пам’яті з високою пропускною здатністю для найвищої продуктивності в генеративних застосунках.

У поєднанні з процесорами NVIDIA Grace із надшвидким з’єднанням NVLink-C2C H200 створює суперчип GH200 Grace Hopper з HBM3e.

Прискорювачі H200 можна розгорнути у будь-яких центрах обробки даних: локальних, хмарних, гібридних, периферійних. Глобальна екосистема виробників партнерів NVIDIA, включаючи ASRock Rack, ASUS, Dell Technologies, Eviden, GIGABYTE, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron і Wiwynn, може оновити свої наявні системи за допомогою H200. Amazon Web Services, Google Cloud, Microsoft Azure та Oracle Cloud Infrastructure стануть одними з перших постачальників хмарних послуг, які розгорнуть станції на базі H200, починаючи з наступного року.

Джерело: VideoCardz

Повідомити про помилку

Текст, який буде надіслано нашим редакторам: