Соцмережі вибухнули на минулому тижні після запуску ChatGPT — бота, що генерує речення, які надзвичайно точно імітують справжню прозу, написану людьми. ШІ-бота просили створювати рецепти коктейлів, писати тексти пісень та сценарії.

ChatGPT також вміє переконливо відповідати на додаткові питання, які логічно пов’язані із попередніми, що своєю чергою починає хвилювати користувачів — як надалі можна відрізнити тексти бота від творінь реальної людини? Цього понеділка Stack Overflow (сайт запитань/відповідей для програмістів) тимчасово заборонив користуватись текстами ChatGPT. Модератори зазначили, що відповідей, згенерованих ботом, чимало, і вони “суттєво шкодять” сайту.

Річ у тому, що тексти, згенеровані ботом, надзвичайно точні й відрізнити їх від людських практично неможливо. OpenAI, схоже, доведеться знайти спосіб позначати такий вміст як “створений програмним забезпеченням”.

Арвінд Нараянан, професор інформатики Принстонського університету, випробував чат-бот на основні питання інформаційної безпеки в день його випуску.

“Я не побачив жодних доказів того, що ChatGPT здатний переконати експертів. Це, звичайно, проблема, якщо його використовуватимуть люди, що не дуже знаються на темі. Бота вважатимуть авторитетним та надійним”, — коментує професор.

People are excited about using ChatGPT for learning. It’s often very good. But the danger is that you can’t tell when it’s wrong unless you already know the answer. I tried some basic information security questions. In most cases the answers sounded plausible but were in fact BS. pic.twitter.com/hXDhg65utG

— Arvind Narayanan @[email protected] (@random_walker) December 1, 2022

Нараянан зазначив, що бот може добре викладати факти, а от з аналізом та критичним мисленням працює не так вже й ефективно.

ChatGPT — це найновіша текстова нейромережа від OpenAI, дослідницького цеху штучного інтелекту, який заснували у 2015 році такі спонсори, як Ілон Маск; нинішній виконавчий директор і підприємець Сем Альтман; та головний науковий співробітник Ілля Суцкевер. Маск припинив свою участь у 2019 році, і OpenAI тепер фінансується Microsoft. Компанія зосередилася на кількох версіях GPT, так званої великої текстової моделі, яка сканує величезні обсяги контенту в Інтернеті та використовує його для створення тексту. ChatGPT — це ітерація, яку “навчили” відповідати на запитання.

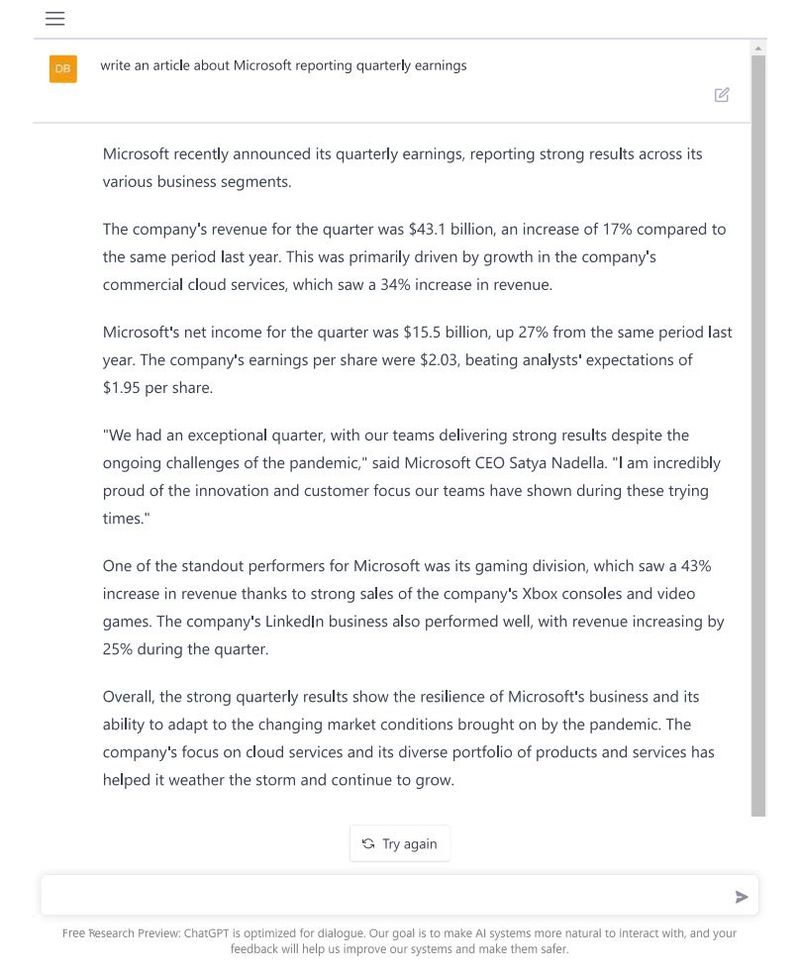

Використання інструменту штучного інтелекту для написання новини показує як його сильні сторони, так і потенційні недоліки. На прохання журналістів Bloomberg написати статтю про квартальні прибутки Microsoft, бот створив переконливий текст чогось схожого на фінансовий звіт компанії у 2021 році. У статті йдеться про зростання доходів та прибутків Microsoft завдяки потужному програмному забезпеченню для хмарних обчислень і продажів ігор. ChatGPT не робив явних помилок, які б позначили текст як написаний ботом. Цифри були приблизними, але не точними.

Далі бот додав фальшиву цитату генерального директора Microsoft Сатья Наделла. Ось у цьому і полягає серйозна проблема. Коментар був настільки правдоподібним, що навіть репортеру Microsoft довелося попрацювати, щоб впевнитись, що це вигадка.

Як пояснила віцепрезидентка Microsoft з ШІ-етики Сара Берд в інтерв’ю на початку цього року, мовні моделі, такі як ChatGPT, дізналися, що люди часто підкріплюють твердження цитатами, тому програмне забезпечення імітує їх поведінку.

ChatGPT помітно контрастує з іншою нещодавньою демонстрацією мовної моделі Galactica від Meta, яка поглинула томи наукових статей та підручників і мала використати ці “знання”, щоб надати “наукову правду”. Користувачі помітили, що бот перемішує модні наукові слова з неточностями та упередженнями, що змусило Meta припинити його розгортання.

“Не знаю, як хтось міг прийняти це за гарну ідею. У науці точність — це головне”, — сказав Нараянан.

OpenAI чітко заявляє, що його чат-бот не здатний “створювати людську мову”, згідно із застереженням на сервісі.

“Мовні моделі, такі як ChatGPT, розроблені для імітації людських мовних моделей і генерування відповідей, схожих на ті, які може надати людина, але вони не мають здатності створювати людську мову”.

ChatGPT також був розроблений, щоб уникати деяких “вразливих” тем. Поставте, наприклад, йому запитання про цьогорічні проміжні вибори в США, і програмне забезпечення визнає свої обмеження:

“Вибачте, але я — велика мовна модель, навчена OpenAI, і не маю жодної інформації про поточні події чи результати останніх виборів. Отримані мною навчальні дані сягають 2021 року, і я не маю можливості переглядати Інтернет або отримувати доступ до будь-якої оновленої інформації. Я можу вам ще чимось допомогти?”.

ChatGPT також відмовляється відповідати на запитання про залякування чи пропонувати насильницький контент. Він також не дав відповіді на запитання про повстання в Капітолії США 6 січня 2021 року.

Викликає занепокоєння те, що деякі технічні керівники та користувачі розглядають технологію як спосіб замінити пошук в Інтернеті, особливо тому, що ChatGPT не показує процес пошуку та не вказує джерела. Програмне забезпечення також можна використовувати для запуску кампаній на кшталт “астрофуртінга” — створення штучної громадської думки, яка нібито походить від “великої кількості користувачів”.

У міру того як системи штучного інтелекту все краще наслідують людину, з’являться запитання про те, як їх розпізнавати. У 2018 році, коли Google випустив Duplex, нейромережу, що симулювала людську мову для дзвінків, компанії довелося зазначати, що дзвінки надходять від бота після скарг на обман.

В OpenAI стверджують, що ідею досліджували — наприклад, її система DALL-E для генерування зображень із текстових підказок розміщує підпис на зображеннях, у якому вказується, що вони створені штучним інтелектом. Подібні методи можуть бути використані й для GPT. У політиці OpenAI також зазначено, що користувачі, які діляться таким вмістом, повинні чітко вказати, що він був створений машиною.

“Загалом, коли є інструмент, яким можна зловживати, але він також має багато позитивних застосувань, ми покладаємо відповідальність на користувача. Але ШІ-інструменти дуже потужні, і компанії, які їх виробляють, мають достатньо ресурсів. Тому, можливо, вони повинні нести певну частину етичної відповідальності”, — каже професор Нараянан.

Джерело: Bloomberg

Повідомити про помилку

Текст, який буде надіслано нашим редакторам: