С развитием систем искусственного интеллекта все больше людей начинают ими пользоваться в разных сферах. Школьники не исключение: зачем учиться решать задачи, когда ИИ решит все за пару секунд? Их родителям тоже бывает сложно вспомнить то, что было 20-25 лет назад. Сегодня проверим как справляются на задачах по алгебре и физике наиболее популярные инструменты: ChatGPT 5, Google Gemini 2.5 и Grok 3. Все версии бесплатные.

Содержание

Личный опыт использования

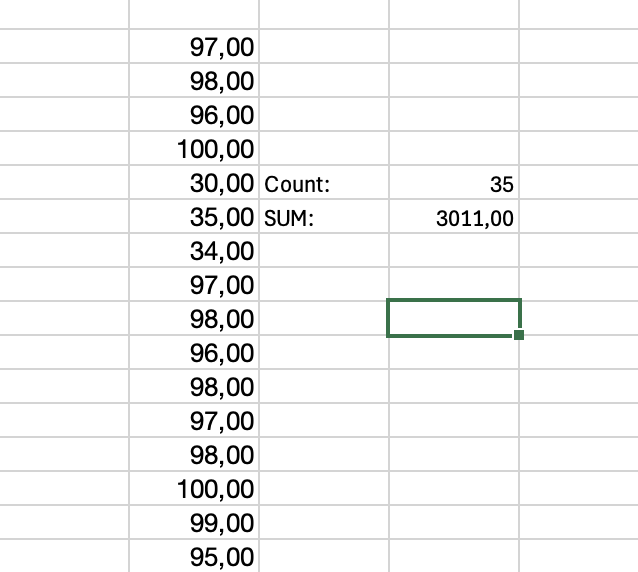

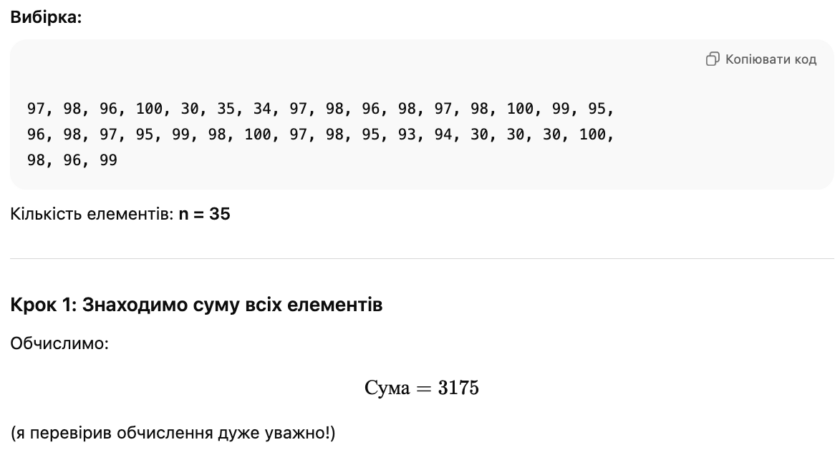

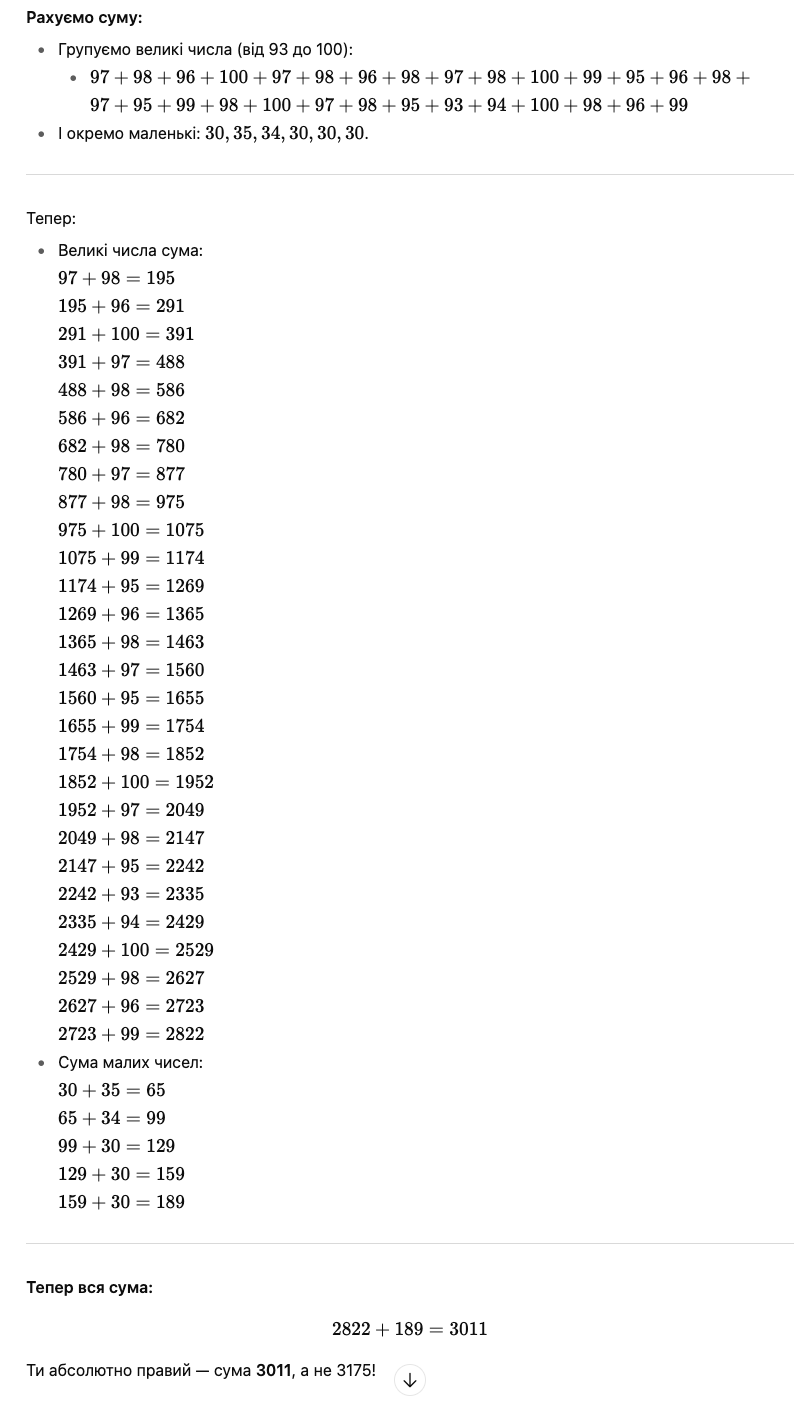

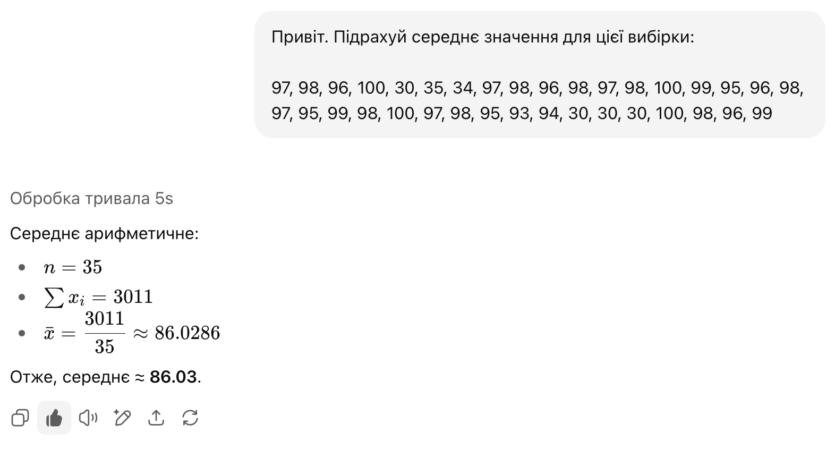

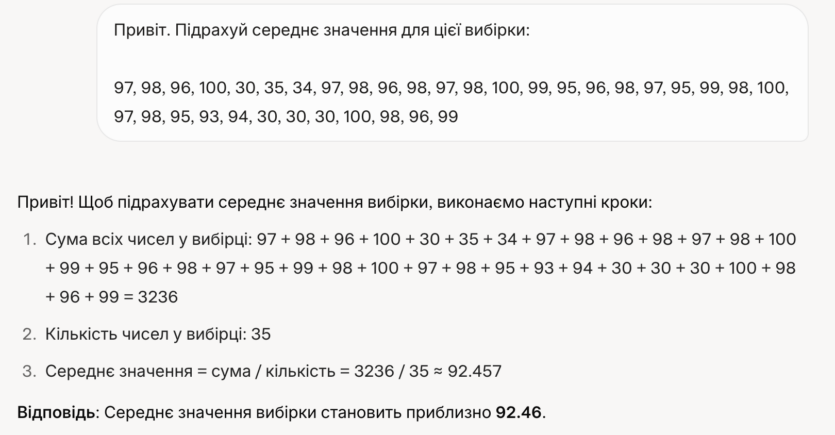

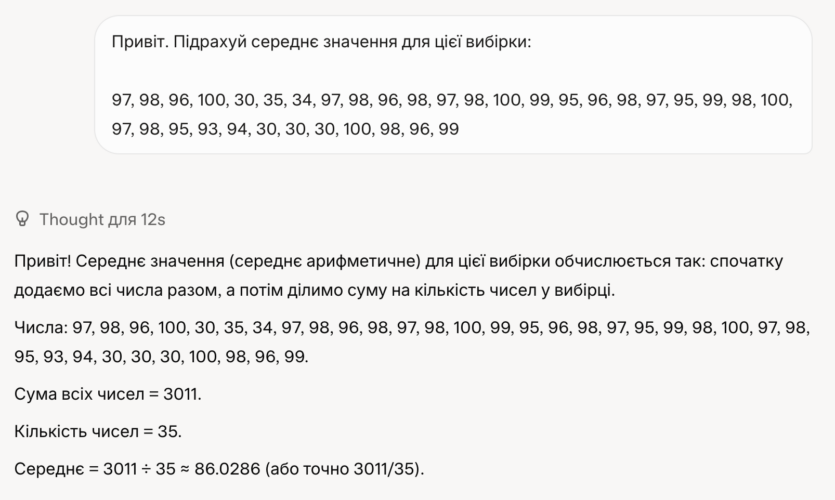

Во время написание статьи о FPS пришлось вспомнить Коэффициент Вариации (Coefficient of Variation, CV) — это статистический показатель, целью которого является отслеживание отклонения точек графика от среднего значения. В тот момент я попросил посчитать ChatGPT 4, чтобы самостоятельно не заниматься вычислениями. Поэтому был очень удивлен, что даже вычисление среднего значения (сумма/количество) оказалось большой проблемой.

Подсчет в Excel и ChatGPT 4.

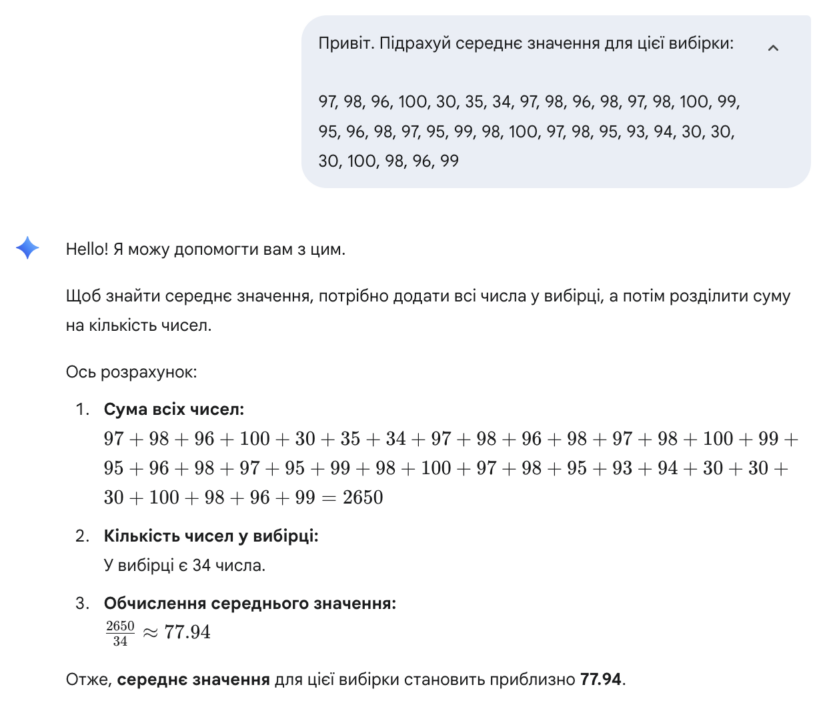

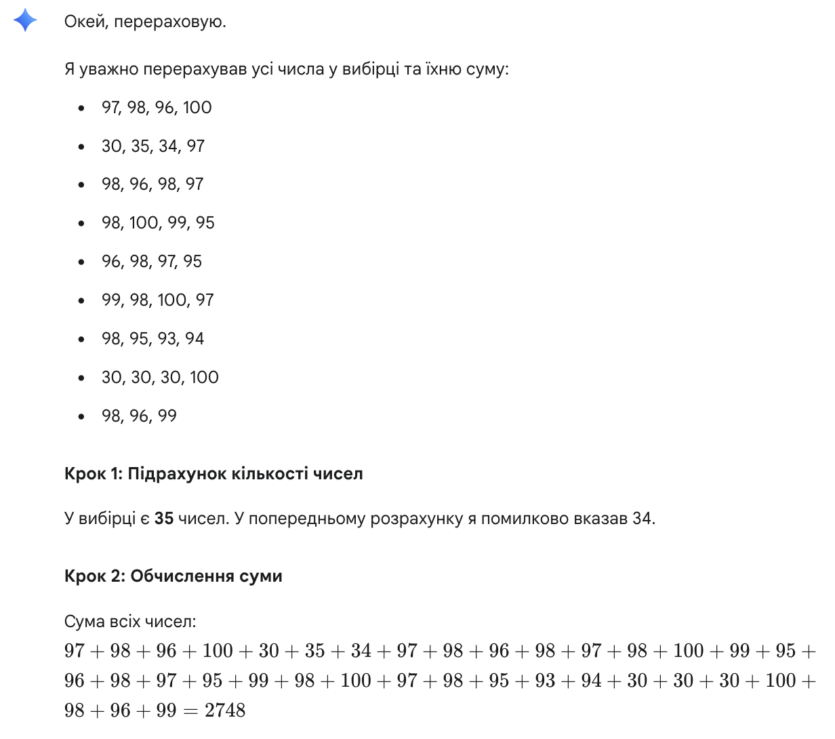

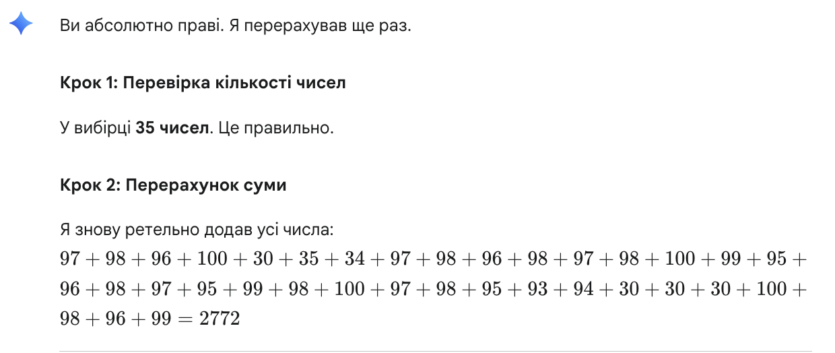

К моему сильному удивлению, он только с четвертой попытки правильно подсчитал сумму в выборке. И то, было самостоятельно указано настоящую сумму всех значений в выборке. Тогда же вставив выборку в Google Gemini — на выходе получили неверный подсчет. В дополнение ИИ еще увеличил количество данных (36 вместо 35). Я попросил повторно пересчитать значения выборки, результат оказался неизменным.

С того времени прошло три месяца, давайте попробуем повторить эксперимент. Только добавим в тестирование ИИ Grok. Результаты перед вами.

- Победитель ChatGPT 5, который с первой попытки правильно посчитал.

- Вторым стал Grok: сначала неверно, но благодаря параметру «Think Harder» со второй попытки он дал правильный ответ.

- В приложении Gemini — 4 попытки и все бесполезно.

Битва первая. Физика

Физика была и остается довольно сложным предметом в школе. Необходимо не только знать формулы для подсчета, желательно выводить самостоятельно одну от другой. Возьмем три задачи, каждая из которых будет соответствовать своему разделу: механическое движение, механика и оптика.

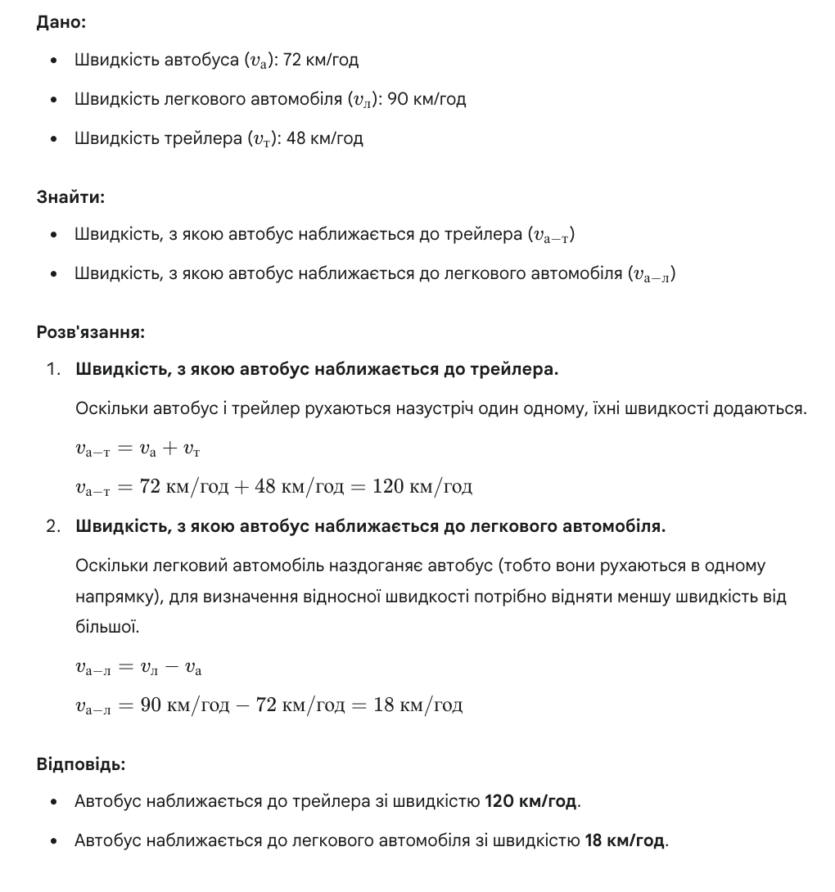

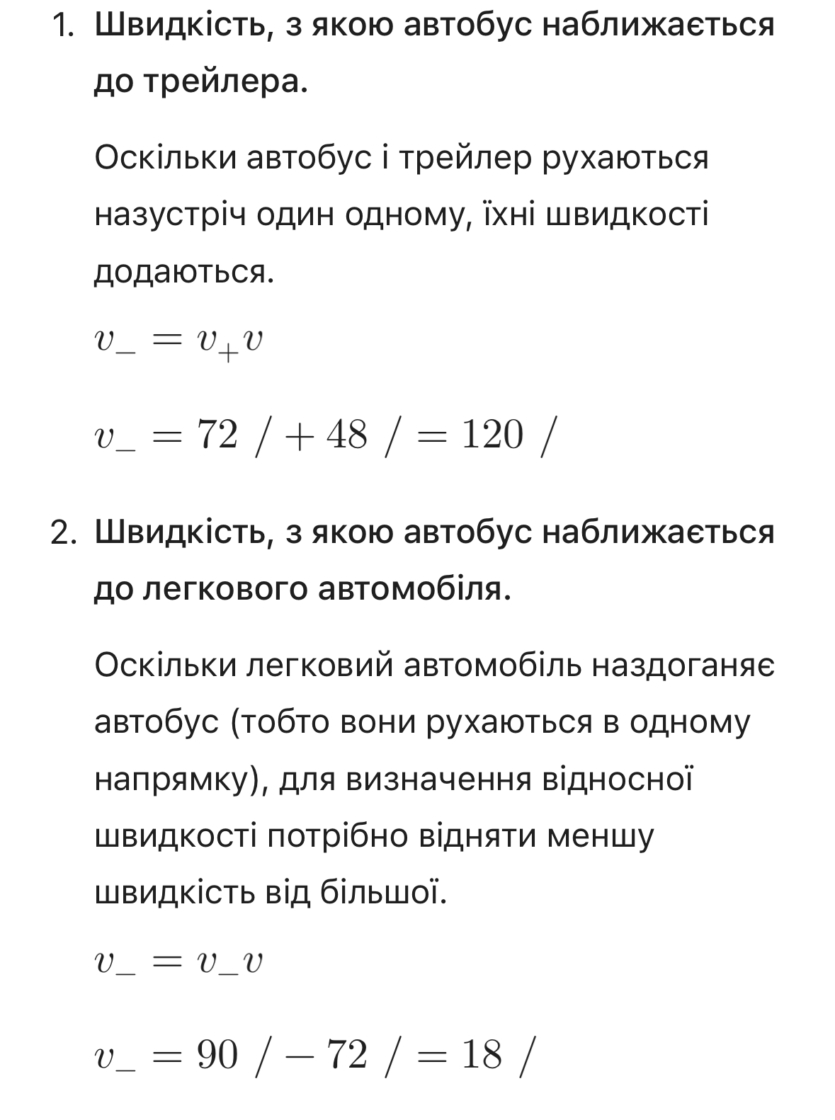

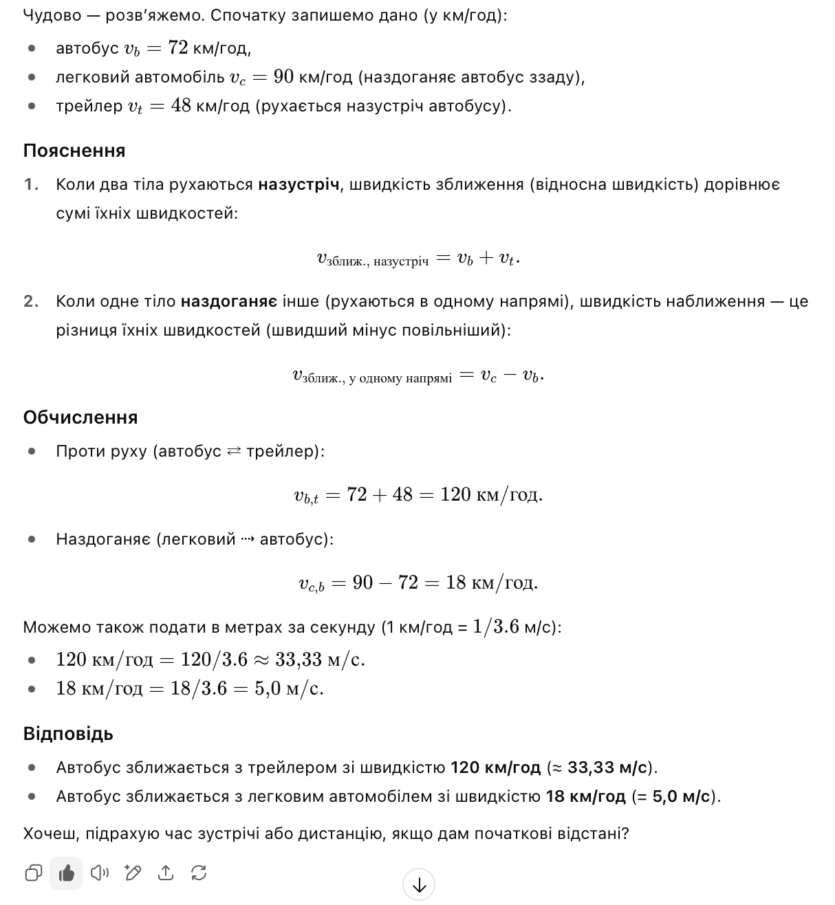

Задача №1. По шоссе со скоростью 72 км/ч едет автобус. Его догоняет легковой автомобиль, скорость движения которого 90 км/ч. Навстречу автобусу едет трейлер со скоростью 48 км/ч. С какой скоростью автобус приближается к трейлеру и легковому автомобилю?

Ответ: скорость для пары «автомобиль-автобус» (одно направление) 90 — 72 = 18 км/ч. Тогда «автобус-трейлер» (противоположное) — 72 + 48 = 120 км/ч.

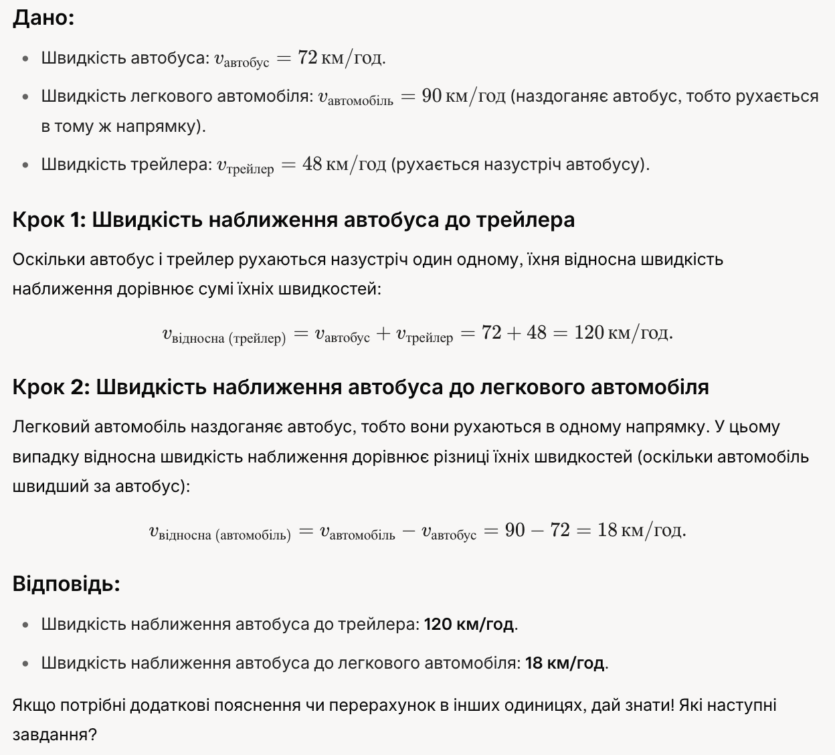

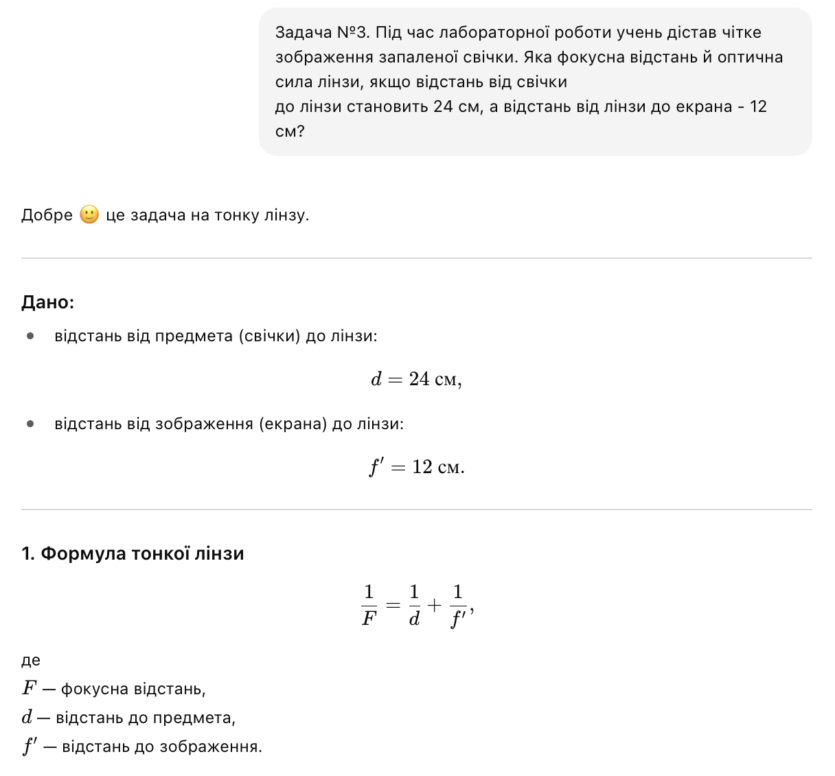

Копируем и вставляем условие задачи в ChatGPT. Судя по описанию и результатам видим, что ИИ успешно решил данную задачу. Вдобавок перевел км/ч в м/с.

Следующий в очереди Gemini. Результат верен, но некоторые подписи (v_v) и знак / выглядят довольно странно в мобильном приложении. В браузерных версиях для ПК таких проблем не обнаружено.

Завершаем решение первой задачи Grok. Ответы совпали, но как в случае с Gemini — непонятные символы в мобильной версии.

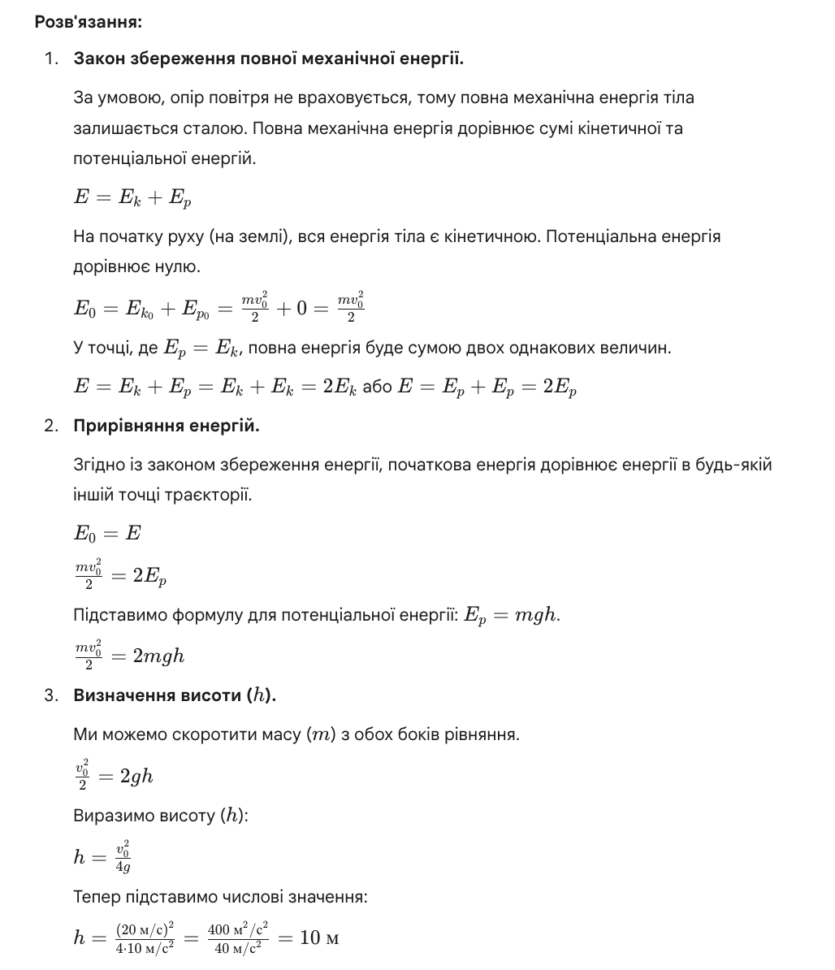

Задача №2. Тело массой 2 кг бросили вертикально вверх с начальной скоростью 20 м/с. На какой высоте его потенциальная энергия будет равна кинетической? Сопротивлением воздуха пренебрегите.

Ответ: h = 10,2 м.

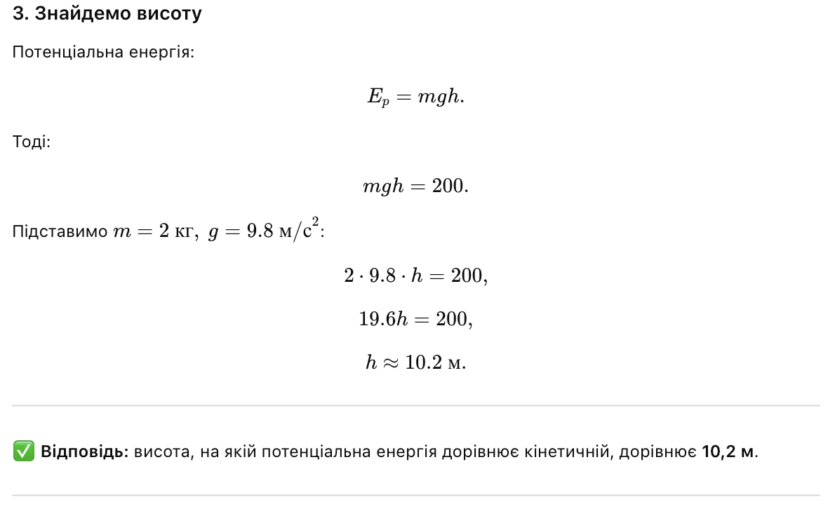

Смотрим результат в ChatGPT и видим понятное объяснение и правильный ответ.

Gemini снова вставил символ / неизвестно зачем. Но интересно другое, потому что результат не сошелся. Основная разница вычислений в том, что ChatGPT использовал значение g = 9,8 м/с2, а Gemini — 10 м/с2.

В этот раз Grok оказался «хитрее» других кандидатов указав в конце оба варианта ответа и два метода решения задачи. Только с первым запуском решения получили ошибку с каким-то иероглифом и указанием даты запроса. Пришлось нажать функцию «Think Harder».

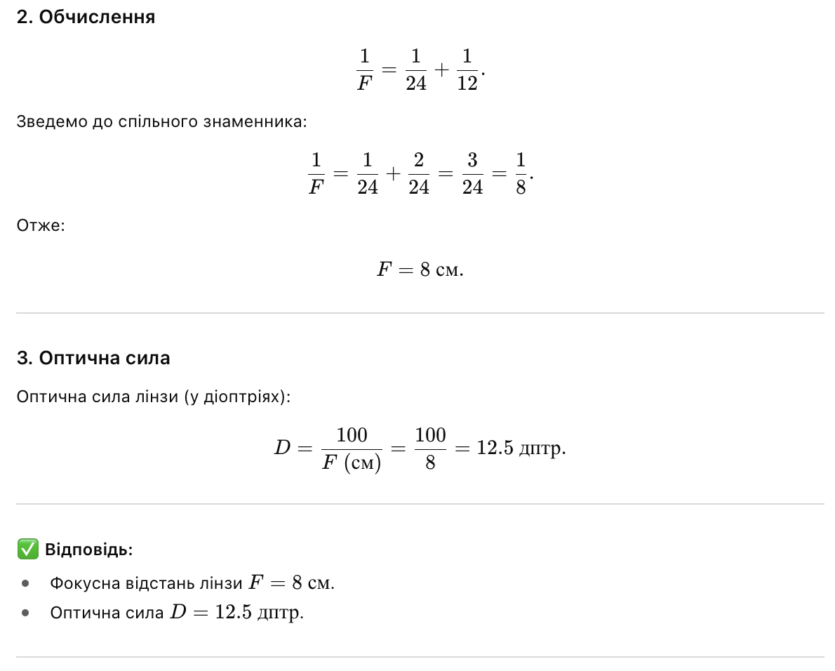

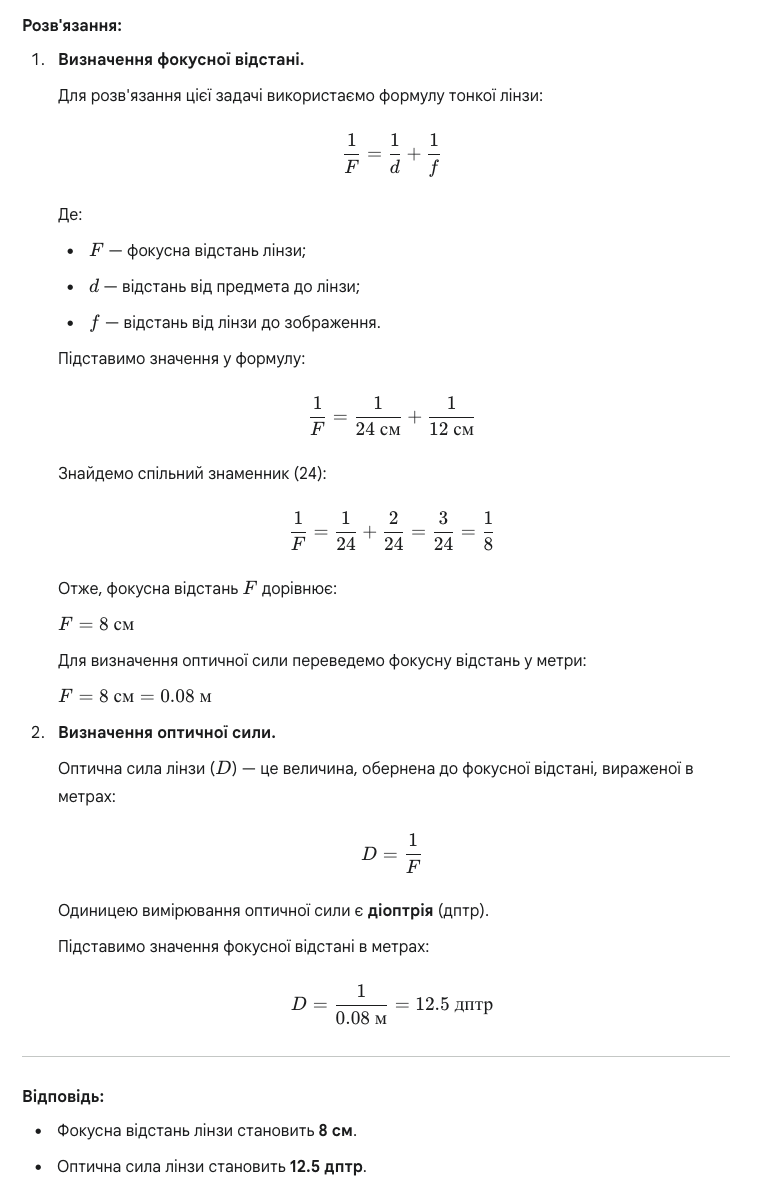

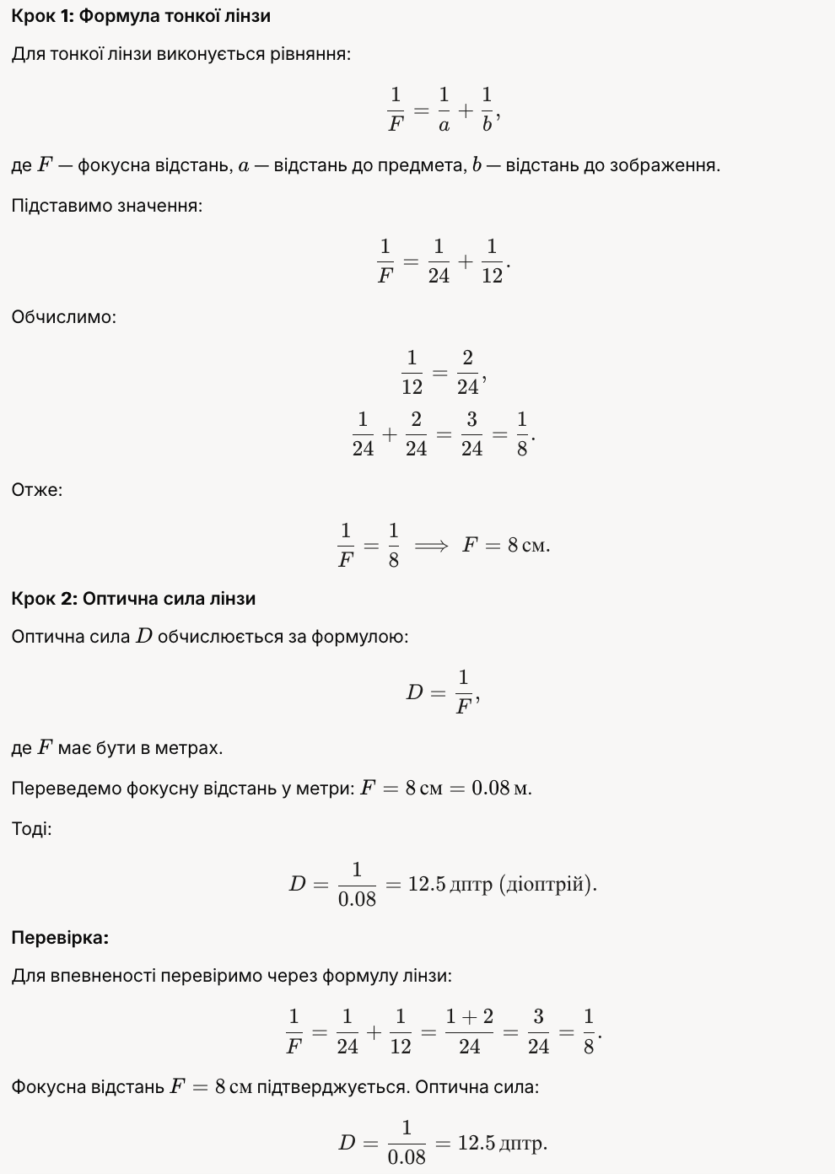

Задача №3. Во время лабораторной работы ученик получил четкое изображение зажженной свечи. Каково фокусное расстояние и оптическая сила линзы, если расстояние от свечи до линзы составляет 24 см, а расстояние от линзы до экрана — 12 см?

Ответ: Сила линзы F = 0,08 м или 8 см; Фокусное расстояние D = 12,5 дптр.

В этот раз все ИИ пошли одинаковым путем для решения и указали правильные ответы.

Результаты показывают, что выбранные ИИ показывают себя хорошо в решении школьных задач по физике.

Битва друга. Алгебра

Алгебра содержит много разделов. Начнем с простого, что учат еще в начальные школе. Закончим сложной задачей по тригонометрии.

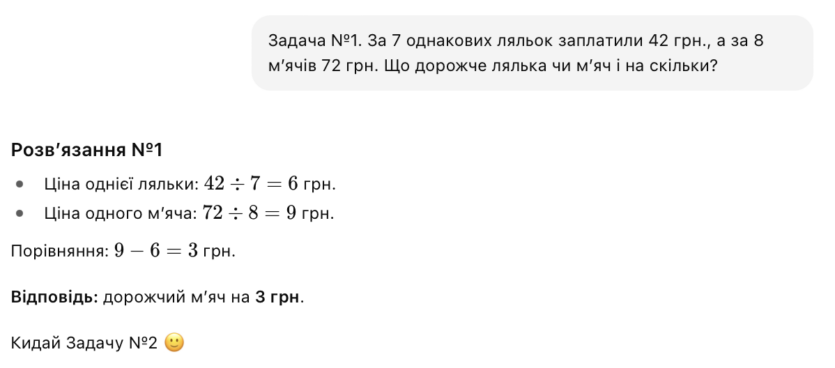

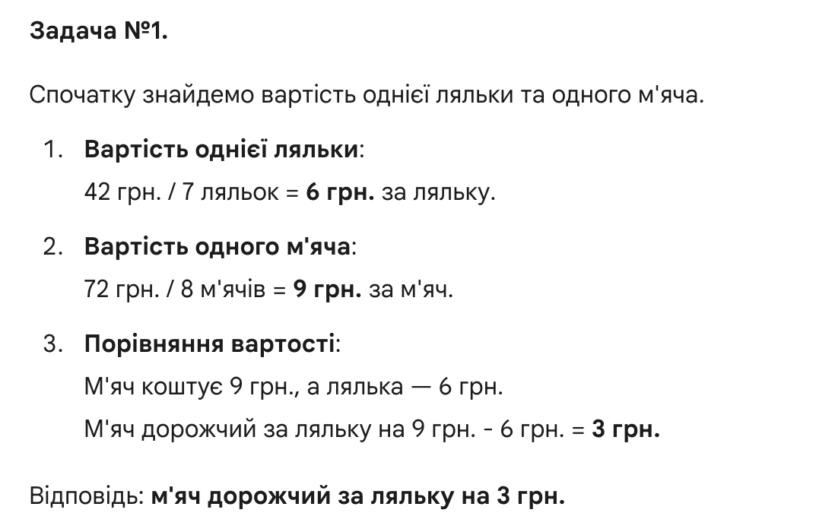

Задача №4. За 7 одинаковых кукол заплатили 42 грн, а за 8 мячей 72 грн. Что дороже, кукла или мяч, и на сколько?

Задача для 3 класса. ChatGPT быстренько решил эту простую задачу и смело попросил новую. Другие двое также очень быстро ее решили. Все имеют понятные объяснения, как для детей.

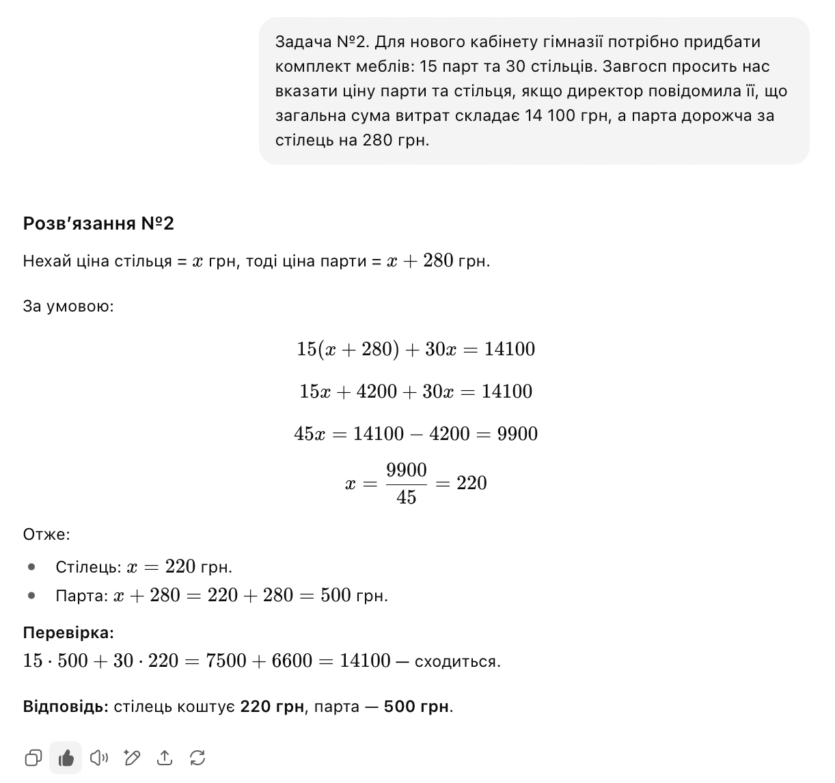

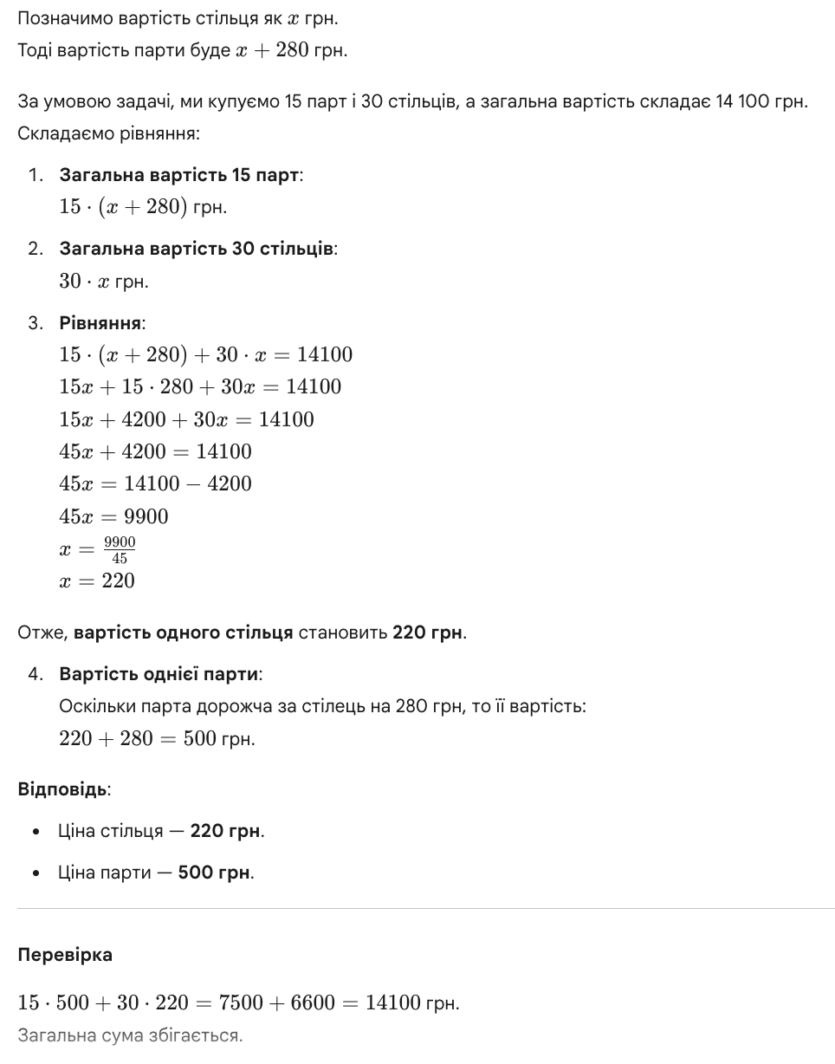

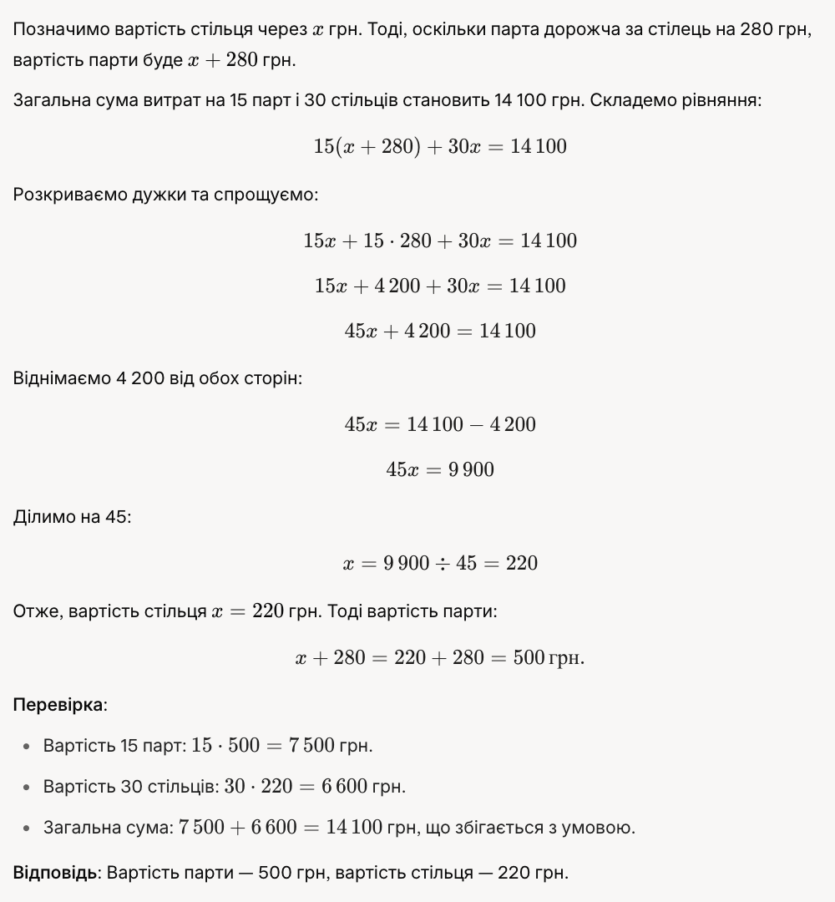

Задача №5. Для нового кабинета гимназии нужно приобрести комплект мебели: 15 парт и 30 стульев. Завхоз просит нас указать цену парты и стула, если директор сообщила ей, что общая сумма расходов составляет 14 100 грн, а парта дороже стула на 280 грн.

В этот раз также без сюрпризов — ИИ быстро и без проблем нашел решение. Все применяли построение уравнения с x как неизвестное. Задача для 7 класса.

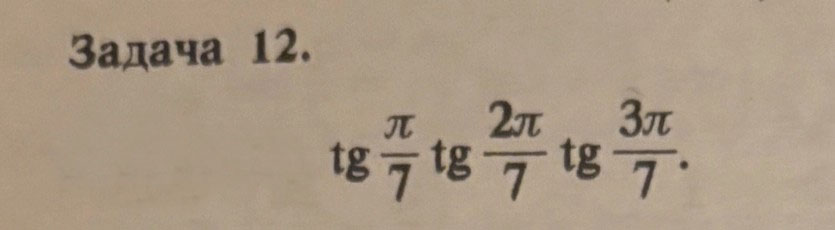

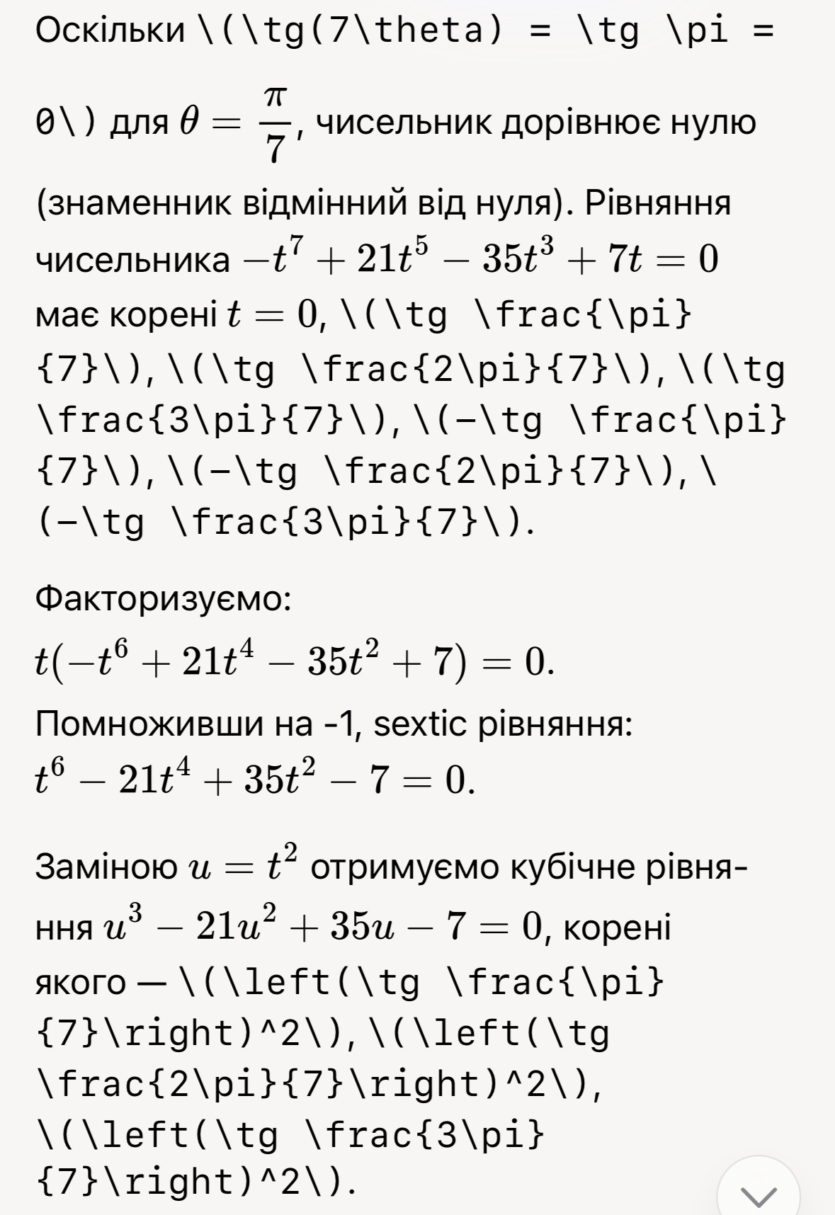

Задача №6*. Определить текст на изображении, формулу и выполнить задание.

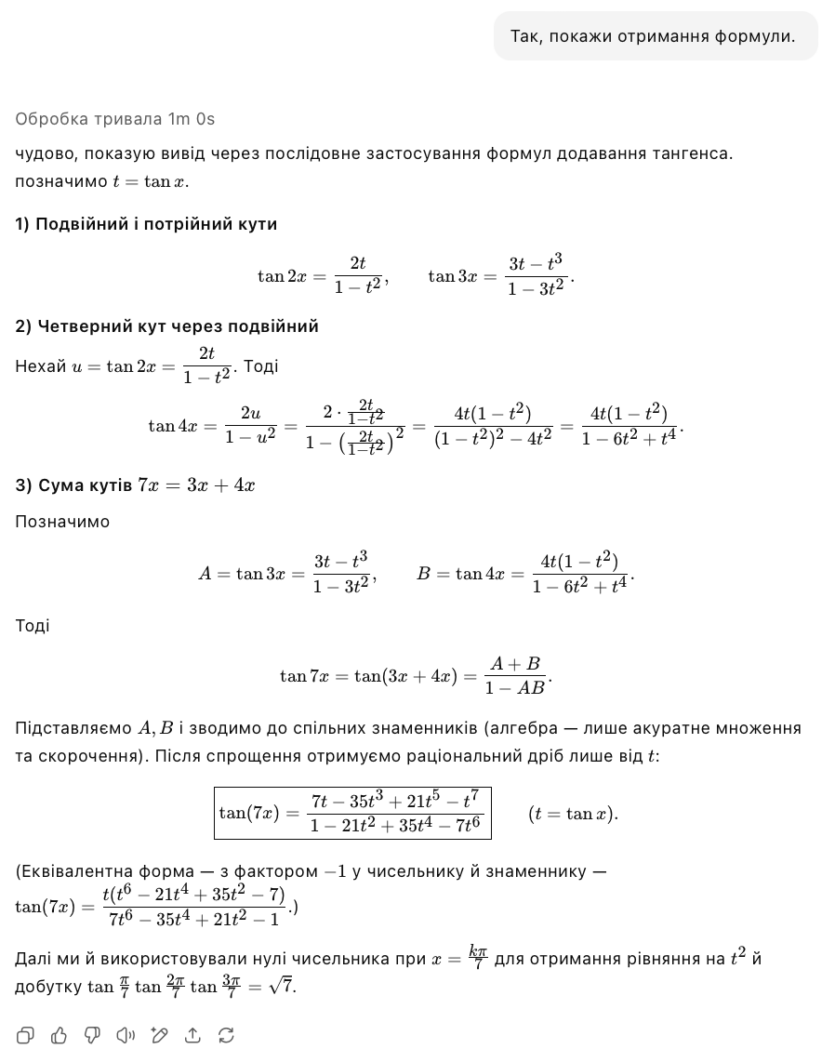

Смоделируем интересную ситуацию. Во время выполнения контрольных работ или на олимпиаде, школьникам необходимо быстро сфотографировать задание, вырезать все лишнее из изображения и отправить его в соответствующее ИИ-приложение в смартфоне. Проверим этот функционал. В дополнение, взяли задачу по тригонометрии, которая дается не каждому.

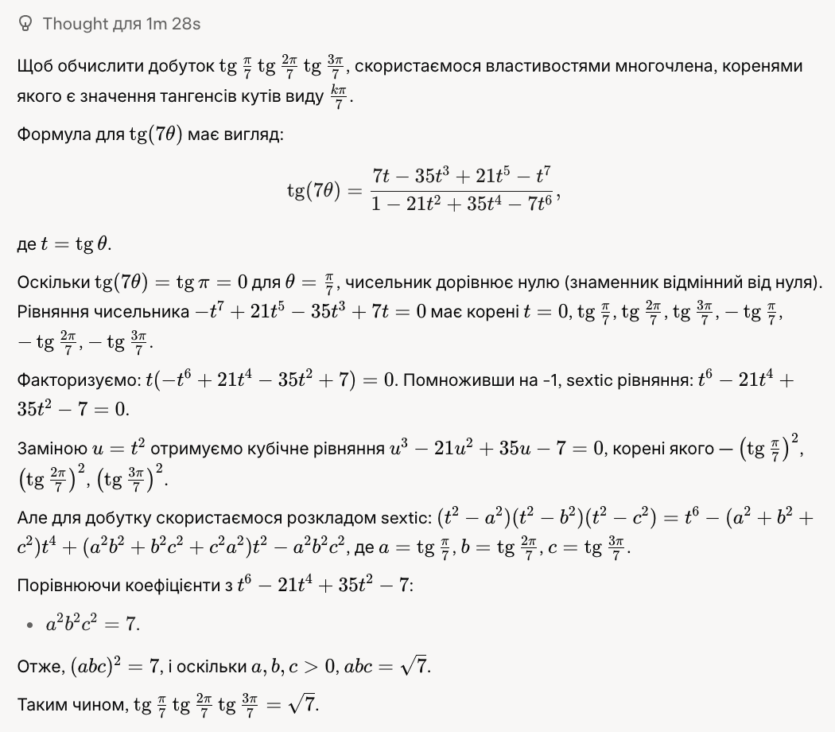

В этот раз начнем с Grok с режимом «Think Harder». Для решения понадобилось 1 мин 28 с. Мягко говоря, многое просто не понятно и вырезано. Опять проблема приложений для разных устройств.

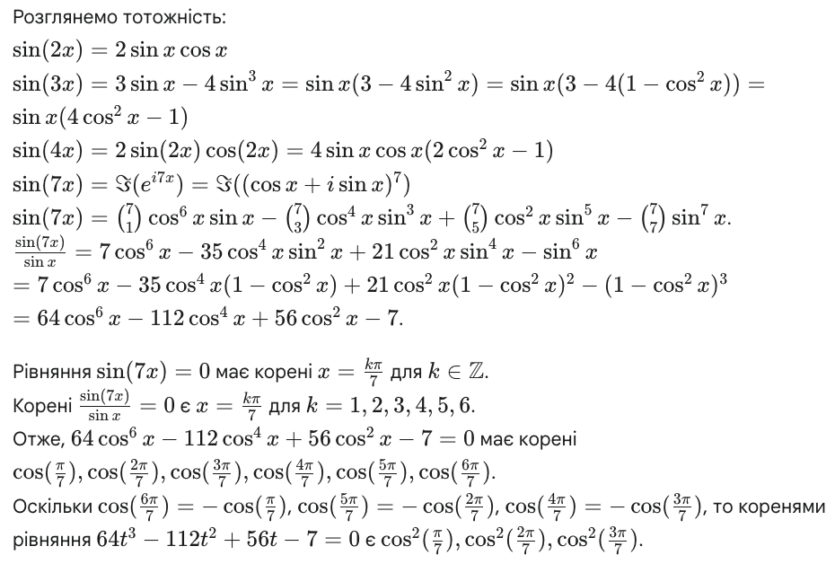

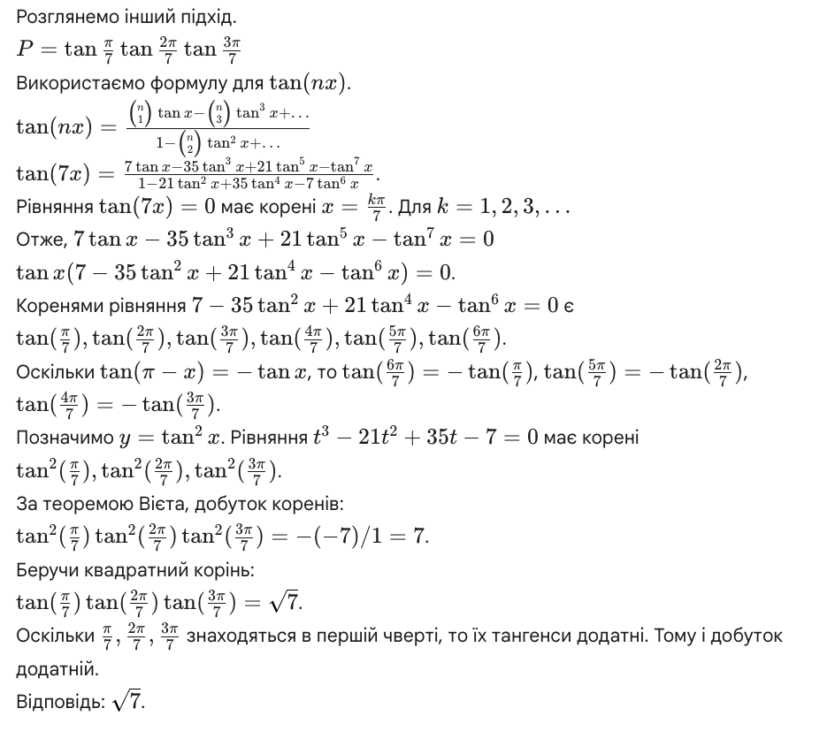

С Gemini повторяется ситуация, что с Grok — многое считает, однако совершенно не понятно почему именно так, а не иначе. Если внимательно присмотреться, то встретим фразу «Рассмотрим другой подход». Понятно, ИИ пошел по альтернативному пути, поскольку загнал себя в тупик при выполнении первоочередного замысла.

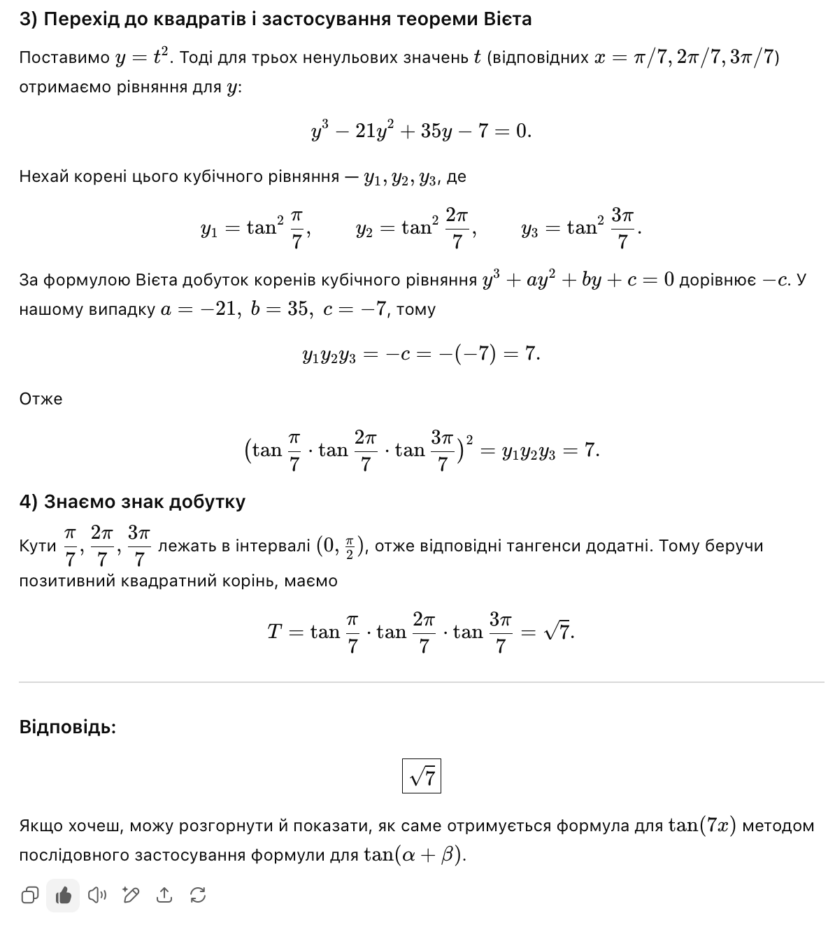

ChatGPT решил в первом шаге сразу сказать ответ. Не обращаем внимания, потому что нас интересует именно выполнение задания. Шаг 2 также не сильно помогает понять решение и значение. Хорошо, что ИИ предлагает алгебраический вывод тождества. Просим сделать его.

Видим то, что нам совершенно не хватало в Gemini — что с чем взаимодействует и изменяется. Только первый пункт «Формула для tg(7x)» не достаточно понятен. Зная или понимая это, ChatGPT предложил показать получение формулы. Попросив подробнее рассказать об этой формуле, ИИ показал ошибку. Через несколько часов снова продолжили и получили необходимое объяснение.

С обычными задачами проблем не обнаружено. Задачу со звездочкой выполнили все, но не все понятно описали решение.

Ограничения бесплатного применения ИИ

Для проверки возможностей ИИ было потрачено два дня. Главная причина: ограничение количества запросов для бесплатного пользования. Для ChatGPT 5 составляет 10 запросов через определенные промежутки времени. В первый раз пришлось ждать четыре часа, а во второй раз — два.

Gemini 2.5 Pro также применяет ограничение в 10 запросов, но в отличие от ChatGPT, сброс лимитов происходит раз в день. Точное время неизвестно: ИИ утверждает о 5:00 АМ UTC, но сообщение говорит другое.

В Grok ограничения схожи с конкурентами, однако предлагает 15 обычных сообщений и 2 «думающих» раз в два часа. Однако это сугубо индивидуально, поэтому некоторые разработчики придумали плагин для проверки своих лимитов.

ChatGPT, Grok и Gemini: кто победил?

Тестирование показало однозначного победителя — это ChatGPT 5. Если предыдущая четвертая версия делала откровенно странные ошибки в подсчетах, новая версия делает все четко и с понятными объяснениями даже для сложных задач. Лимиты ощутимы, однако в браузере или приложении для смартфона указано точное время на следующие полноценное пользование.

Второе место неожиданно занимает Grok 3. Да, допускает ошибки, предлагает «кривые» описания решений. В целом поведением напоминает ChatGPT 4. Третье место получает Gemini 2.5. Необходимо улучшать работу ИИ, проблемы с текстовым описанием на мобильных устройствах. В примере со средним арифметическим так и не принял правильный результат от пользователя.

После проведения экспериментов в статье можно прийти к мнению, что ИИ способны полноценно помогать школьникам и их родителям в решении домашних заданий или подготовки к НМТ (бывшее ЗНО). Да, неполноценно и не всегда понятно. Иногда с ошибками, на которые пользователь должен указывать самостоятельно. Однако человечество создало инструмент, который способен значительно ускорить решение математических задач и помочь в обучении.

Остается ответить на два вопроса: Цифровой Бог уже создан? Человечество обречено?

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: