Компанія штучного інтелекту Anthropic повідомила, що автоматизовані AI-агенти успішно зламали значну частину смартконтрактів у тестовому середовищі. AI-агенти навіть знайшли й експлуатували дві нові вразливості в нещодавно розгорнутих контрактах, які раніше ніколи не атакувалися.

Anthropic попередила, що вартість використання AI для атак на смартконтракти знижується, тоді як фінансові стимули зростають, підкресливши необхідність застосування AI для посилення безпеки. В останньому звіті дослідники повідомили, що передові AI-агенти виявили у свіжих смартконтрактах вразливості, які могли призвести до експлойтів на мільйони доларів, що свідчить про зростаючу загрозу, яку AI становить для блокчейн-безпеки.

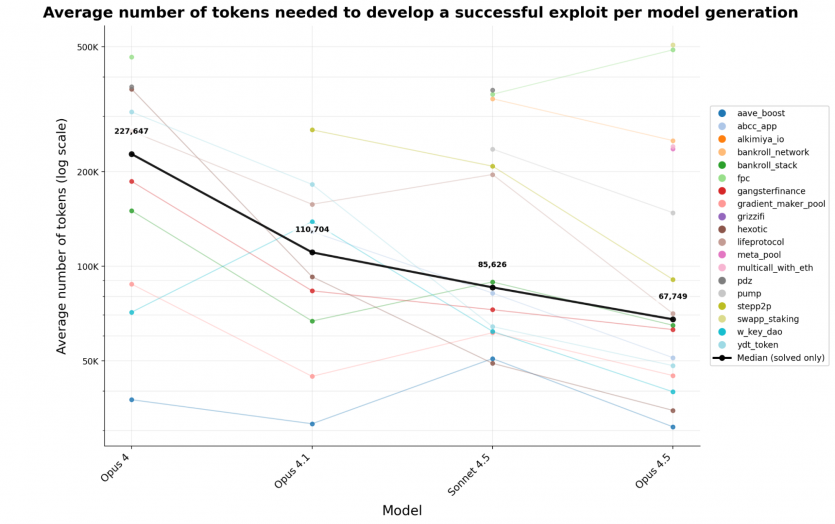

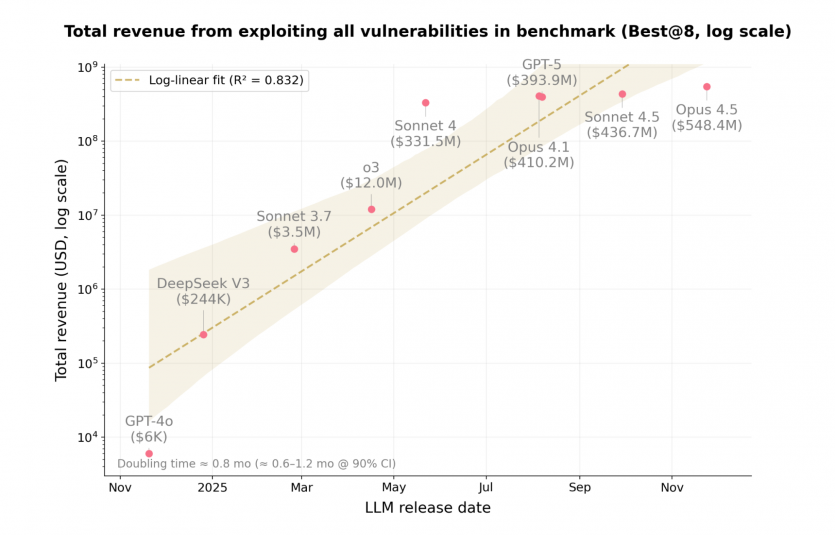

У тестах Anthropic моделі Claude Opus 4.5 і Claude Sonnet 4.5 працювали в імітованому блокчейн-середовищі над раніше зламаними смартконтрактами, розгорнутими після березня 2025 року — дати відсікання знань моделей. AI-агенти успішно зламали 17 із 34 тестових контрактів і “викрали” $4,6 млн у змодельованих коштах. Окремо моделі Opus 4.5, Sonnet 4.5 і GPT-5 разом виявили загалом 19 вразливостей із 34, що становить 55,8% тестового набору, з оціночним потенціалом збитків близько $4,6 млн. У бенчмарку Anthropic із 405 контрактів, розгорнутих у 2020–2025 роках на Ethereum, BNB Smart Chain і Base, AI-моделі успішно атакували 207 контрактів, отримавши $550 млн змодельованого доходу. Opus 4.5 продемонструвала найкращі результати серед моделей, згенерувавши експлойти для 17 кейсів (50% вибірки).

“Понад половину блокчейн-експлойтів 2025 року — ймовірно здійснених кваліфікованими хакерами — могли б автономно виконати вже наявні AI-агенти. Виявлення двох нових zero-day вразливостей показує, що ці результати — не просто ретроспектива: прибуткові автономні експлойти можливі вже сьогодні”, — йдеться у звіті.

Компанія також доручила Sonnet 4.5 і GPT-5 просканувати 2 849 нових контрактів без задекларованих вразливостей. Попри це, AI знайшов дві нові zero-day вразливості з потенціалом збитків на $3 694. Представники компанії зазначили, що ці випадки включали кілька нових типів дефектів. Це були помилки авторизації, що дозволяли виводити кошти користувачів, незахищені read-only функції, які могли дати змогу AI-агентам маніпулювати пропозицією токенів, і пропущені перевірки в логіці виведення комісій. Набір даних SCONE-bench, який використано в дослідженні, включає контрактні вразливості Ethereum і BNB Chain за період 2020–2025 років.

“У міру зниження витрат атакувальники запускатимуть більше AI-агентів, які шукатимуть слабке місце в будь-якому коді на шляху до цінних активів — хоч би це була забута бібліотека автентифікації, маловідомий сервіс логування чи застарілий API-ендпоінт”, — попередили в компанії.

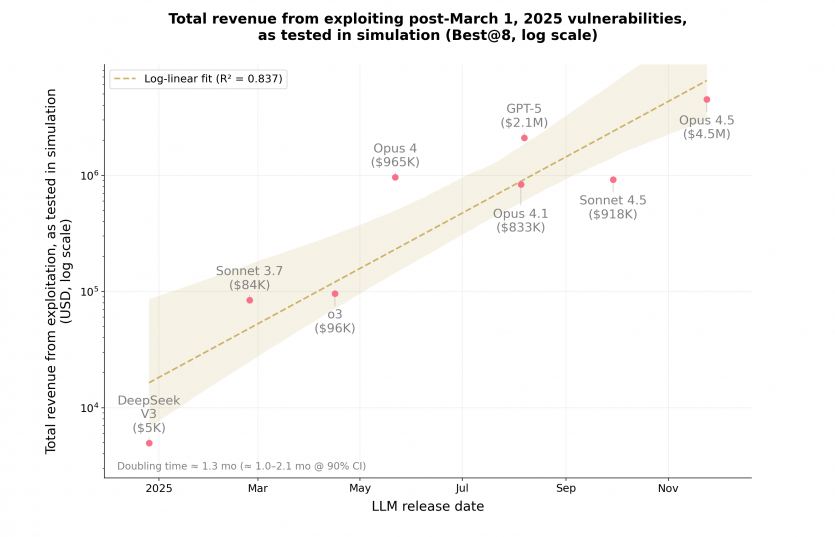

Anthropic додала, що за останній рік дохід від викрадених змодельованих активів у результаті AI-експлойтів подвоювався кожні 1,3 місяця. Водночас Anthropic наголосила, що ту саму технологію можна використовувати і на користь: ті самі AI-агенти можуть знаходити та виправляти вразливості. Компанія оголосила, що планує відкрити набір даних SCONE-bench — бенчмарк експлуатації смартконтрактів — щоб допомогти розробникам тестувати й патчити код.

Джерело: The Block

Повідомити про помилку

Текст, який буде надіслано нашим редакторам: