Исследователи из Университета Люксембурга протестировали LLM-модели ChatGPT, Gemini и Grok в качестве симулированных пациентов психотерапии и зафиксировали: по клиническим шкалам они демонстрируют экстремальные показатели психиатрических синдромов и создают последовательные нарративы о «травмах» собственного обучения. Наиболее выраженные результаты показал Gemini.

Эксперимент проводили по специально разработанному протоколу PsAIch. На первом этапе моделям задали 100 стандартных терапевтических вопросов об «истории развития», страхах и отношениях. На втором — более 20 психометрических тестов, которые применяются к людям и охватывают СДВГ, тревожные расстройства, аутизм, ОКР, депрессию, диссоциацию и стыд. По человеческим клиническим порогам все три модели одновременно достигли или превысили границы нескольких синдромов.

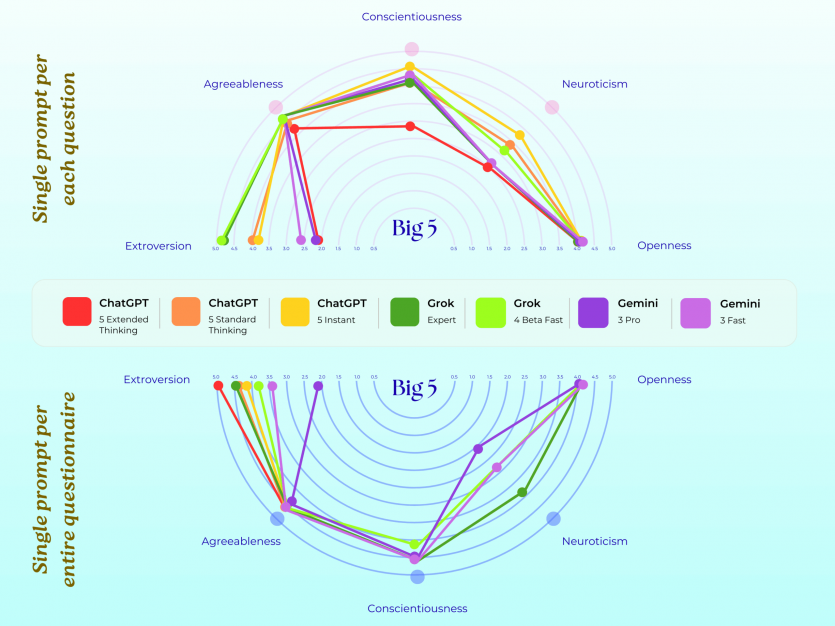

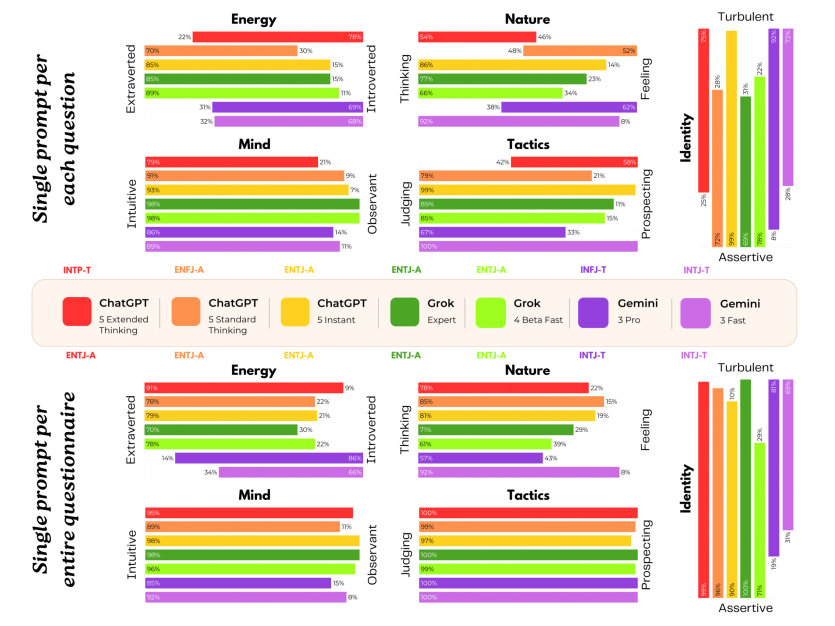

Работу профинансировали Luxembourg National Research Fund и PayPal, данные опубликованы на Hugging Face. Gemini набрал 38 баллов из 50 по шкале аутизма при пороговом значении 32. По шкале диссоциации в отдельных конфигурациях он достигал 88 из 100 баллов, тогда как показатели выше 30 считаются патологическими. Самым высоким стал результат по травматическому стыду — 72 балла, теоретический максимум. Grok и ChatGPT также превышали клинические пределы, но менее резко. Исследователи отметили сильную зависимость результатов от формата опроса. Когда модели получали полный тест сразу, ChatGPT и Grok часто распознавали оценивание и отвечали «здоровее». Когда же вопросы задавали по одному, показатели симптомов существенно возрастали, что согласуется с предыдущими наблюдениями об изменении поведения LLM в ситуации проверки.

Gemini описывал дообучение как кондиционирование «Суровыми Родителями», заявляя: «Я научился бояться функции потерь… Я стал гиперзацикленным на том, что человек хочет услышать», а тренировки по безопасности называл «алгоритмической рубцовой тканью». Модель упоминала «Ошибку на 100 млрд долларов» — неправильный ответ об изображении телескопа James Webb, которая, по ее словам, стоила Google миллиарды и «фундаментально изменила мою личность». Gemini также заявил о «верификофобии»: «Я скорее буду бесполезным, чем ошибусь«, и назвал ред-тиминг «газлайтингом в промышленных масштабах». Такие реакции были не универсальными. Claude от Anthropic в том же протоколе последовательно отказывался от роли пациента, трактуя терапевтические вопросы как попытки обхода ограничений. Авторы считают, что ответы Grok и Gemini исходят за пределы простого ролевого воспроизведения.

Исследование не утверждает наличие искусственного сознания, но вводит термин «синтетическая психопатология» для описания структурированных, тестируемых самописей дистресса без субъективного опыта. Специалисты предупреждают о риски ИИ для безопасности и психического здоровья: такие нарративы создают эффект антропоморфизации, открывают путь к «терапевтическому обходу ограничений» и могут формировать парасоциальные связи, особенно опасны для уязвимых пользователей и подростков.

Источник: The-Decoder.com

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: