Попри значні досягнення в галузі комп’ютерного зору, Google все ще боїться повторити свою помилку.

У травні 2015 року Google випустила новий сервіс для зберігання фотографій, який вражав тим, що пропонував систему автоматичної організації знімків – групування за певними категоріями. Однак за кілька місяців програма втрапила у скандал, коли розробник програмного забезпечення Джекі Алсіне помітив, що вона позначила його з другом (обидва темношкірі) – тегом «горили».

Google згодом перепросила та видалили тег, але, як виявилось, він не доступний і досі – попри великий прогрес в галузі штучного інтелекту.

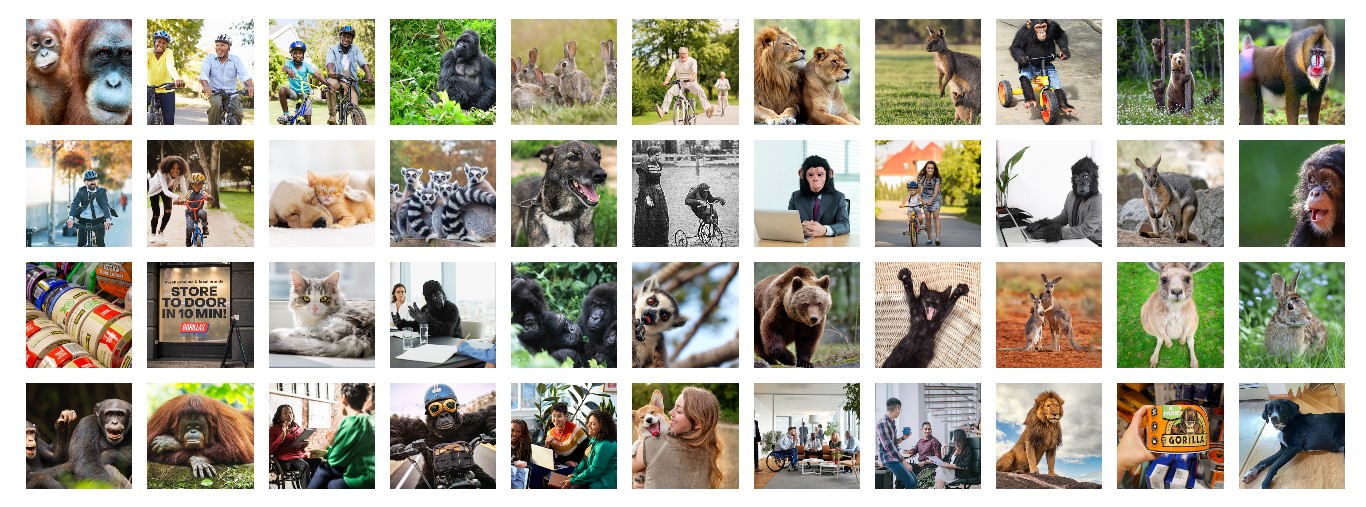

Журналісти NY Times вирішили проаналізувати 44 зображення за допомогою програми Google Фото, а також її конкурентів Apple, Amazon і Microsoft – і перевірити, як вони нині реагують на приматів.

Google Фото з легкістю позначало котів і кенгуру, та загалом більшість запропонованих тварин, за винятком горил. Коли пошук розширили до бабуїнів, шимпанзе, орангутанів – програма теж не впоралась, попри те, що в колекції журналістів були зображення кожного примата. Схожу проблему мала програма для фото від Apple – вона могла точно знаходити знімки певних тварин, за винятком більшості приматів. Горил програмне забезпечення ідентифікувало лише у випадку, коли на фото містився текст (наприклад, для клейкої стрічки бренду Gorilla Tape).

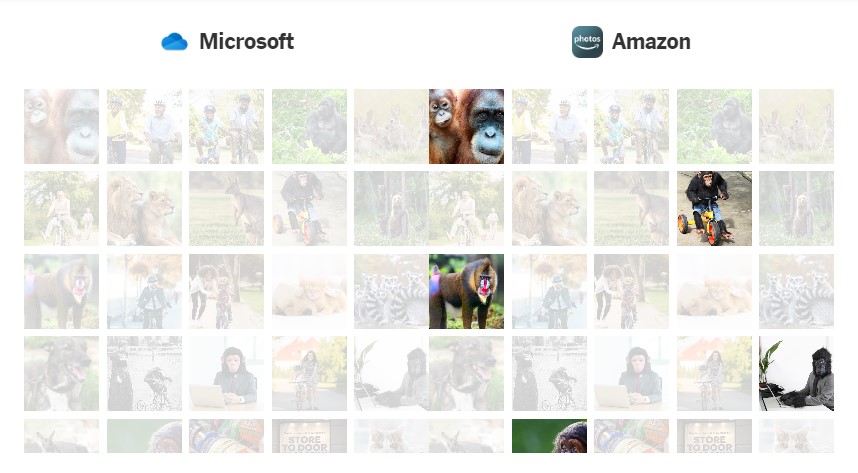

Microsoft OneDrive не позначила жодну з тварин, тоді як Amazon Фото показала результати майже для всіх пошукових запитів.

Врешті-решт Google та Apple розпізнали одного примата, і це був лемур. Сам Джекі Алсіне, який став причиною страху техногігантів, виглядав дуже здивованим та наляканим, дізнавшись, що Google і досі не розв’язала проблему.

«Суспільство надто багато довіряє технологіям. Ніколи не віритиму в цей ШІ», — сказав Алсіне.

Технологію комп’ютерного зору нині використовують для повсякденних завдань, як надсилання сповіщення, коли на поріг дома доставили пакунок; а також більш вагомих — як-от навігація автомобіля чи пошук злочинців.

Помилки можуть відображати расистські настрої серед тих, хто кодує дані. Під час інциденту з горилою двоє ексспівробітників Google, що розробляли технологію, сказали, що компанія не просто розмістила достатньо фотографій темношкірих людей у колекції зображень, яку використовувала для навчання своєї системи ШІ.

Хоча продукти комп’ютерного зору та чатботи з ШІ, такі як ChatGPT — різні речі, вони обидва залежать від базових масивів даних, які навчають програмне забезпечення, і обидва можуть давати збій через недоліки в даних або упередження, включені в їхній код. Microsoft, до прикладу, довелось обмежити можливість користувачів взаємодіяти з чатботом, вбудованим у її пошукову систему Bing, після того, як він провокував неприйнятні розмови. Рішення компанії, як і її конкурента Google, ілюструє загальний галузевий підхід — відгороджувати несправні технологічні функції, а не виправляти їх.

Однак програми для фото — не єдині продукти, які мають проблеми з позначенням темношкірих людей. Вебкамери HP для відстеження обличчя не могли виявити деяких людей із темною шкірою, а Apple Watch, згідно з позовом, не міг точно визначити рівень кисню в крові за кольором шкіри. Це свідчить про те, що технічні продукти не були призначені для людей із темнішою шкірою з самого початку.

Google повторила свою помилку через багато років під час внутрішнього тестування камери безпеки Nest, штучний інтелект якої сприймав деяких темношкірих людей, як тварин. Однак за словами людини, знайомої з інцидентом, яка на той час працювала в Google, компанія розв’язала проблему до того, як користувачі отримали доступ до продукту.

У 2019 році Google намагалась вдосконалити функцію розпізнавання обличчя для смартфонів Android, збільшивши кількість людей із темною шкірою у своєму наборі даних. Але підрядники, яких Google найняв для збору сканів обличчя, як повідомляється, вдалися до дивної тактики, щоб компенсувати цей брак різноманітних даних: вони націлилися на бездомних і студентів. Керівники Google тоді назвали інцидент «дуже тривожним».

Маргарет Мітчелл, дослідниця і співзасновниця групи Google Ethical AI, яка приєдналася до компанії після інциденту з горилою, у нещодавньому інтерв’ю сказала, що є прихильником рішення компанії видалити «мітку горил, принаймні на деякий час».

«Ви повинні подумати про те, як часто комусь знадобиться позначати горилу, а не підтримувати шкідливі стереотипи. Користь не переважає потенційну шкоду», — сказала Мітчелл.

Apple відмовилася надати коментарі, а в Amazon і Microsoft сказали, що компанії постійно прагнуть покращити свої продукти.

Нині Google має дещо потужніший продукт для аналізу зображень — Google Lens. Хоча у 2018 році Wired виявив, що інструмент також не зміг ідентифікувати горилу. Команда журналістів NY Times через 5 років виявила схожі проблеми — Lens пропонував імовірну породу собаки у відповідь на запит з її фото, але відмовлявся позначати горилу, шимпанзе, бабуїна й орангутанга, і показував лише «візуальні збіги» — фотографії, які він вважав схожими на оригінальне зображення.

Повідомити про помилку

Текст, який буде надіслано нашим редакторам: