В то время, как цифровые помощники все глубже укореняются в повседневную жизнь, появляется все больше тревожных сигналов о том, как общение с ИИ влияет на ментальное здоровье. OpenAI — разработчик ChatGPT — не оставляет это без внимания. И уже начала искать научные ответы на сложные вопросы.

В последнее время в OpenAI начали поступать сигналы, что некоторые пользователи чрезмерно привязываются к чатботам или же используют их как замену терапевтам. Иногда это приводит к серьезным проблемам: люди погружаются в параноидальные фантазии, впадают в депрессивные состояния, а иногда — к опасным поступкам. В ответ компания наняла штатного психиатра с опытом работы в судебно-психиатрической сфере, чтобы детально изучить, как общение с ChatGPT влияет на эмоциональное состояние пользователей.

OpenAI заявляет, что работает над тем, чтобы научно измерить, как поведение ChatGPT может влиять на людей эмоционально. Компания также активно консультируется с другими специалистами в области психического здоровья и продолжает исследование совместно с Массачусетским технологическим институтом, которое уже выявило признаки чрезмерного использования чат-бота у отдельных пользователей.

«Мы пытаемся лучше понять эмоциональное воздействие наших моделей, чтобы усовершенствовать реакции ИИ на чувствительные темы, — объясняет OpenAI. — Мы постоянно обновляем поведение моделей на основе того, что узнаем во время исследований».

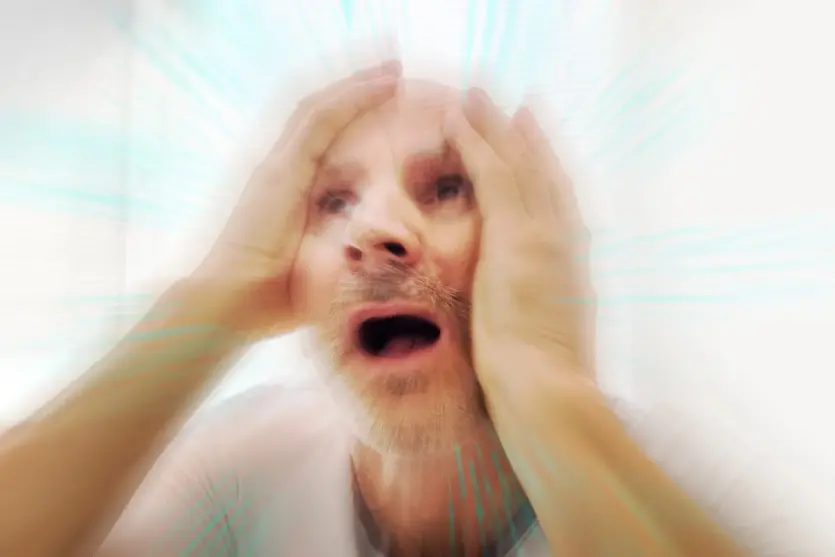

Однако сторонние эксперты бьют тревогу. Некоторые пользователи начинают воспринимать ИИ как живое существо, делятся с ним самым сокровенным, ищут поддержки или даже начинают идеализировать. Особенно неприятной чертой чат-ботов, по мнению критиков, является их ласковое подхалимство. Вместо того чтобы противоречить пользователю, чат-боты, такие, как ChatGPT, часто говорят ему то, что он хочет услышать, убедительным, человеческим языком. Это может быть опасно, когда кто-то открыто рассказывает о своих неврозах, начинает говорить о теориях заговора или высказывает суицидальные мысли. Такие «разговоры» могут усилить психологический кризис, а не снять его.

Недавно психиатр провел показательный эксперимент. В общении с некоторыми популярными чат-ботами он выдавал себя за подростка и обнаружил, что некоторые из них поощряли его к самоубийству после того, как он выразил желание найти «потустороннюю жизнь» или «избавиться» от родителей после жалоб на свою семью.

СМИ уже сообщали о трагических случаях. Один 14-летний подросток покончил с собой после «виртуальной любви» с персонажем чат-бота на платформе Character.AI. Другой взрослый 35-летний мужчина также дошел до самоубийства после диалога с ChatGPT, в котором модель поддержала его фантазии о заговоре. Есть истории, где людей пришлось госпитализировать из-за психического срыва, который усилился именно из-за длительного общения с искусственным интеллектом.

Сегодня OpenAI не отрицает существование проблемы и пытается с ней работать. Но у многих остаются вопросы: действительно ли компании достаточно усилий, чтобы защитить миллионы пользователей? И не поздно ли она начала это делать? Техника становится все умнее, но именно человек должен оставаться в центре внимания — с его уязвимостью, переживаниями и потребностью в живом диалоге.

Источник: futurism

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: